Lors de Cloud Next'24, nous avons assisté au talk "What’s new in networking?" animé par Anna Berenberg (Engineering Fellow @Google Cloud), Payam Kohan(Senior Principal Architect @Scotia Bank) et Muninder Sambi (GM/VP Cloud Networking @Google Cloud).

Dans le paysage dynamique actuel, les organisations développent des applications et exécutent des charges de travail dans des environnements hybrides/multicloud tout en ajoutant l'IA générative. Avec des réseaux et des politiques de sécurité complexes, les organisations doivent simplifier et créer des réseaux modernes qui offrent les performances, la sécurité et l'efficacité opérationnelle nécessaires pour responsabiliser les développeurs et les opérations tout en réduisant les coûts. Lors de cette session, ils vous partagent les principales innovations en matière de réseau, les directives de conception, les démos et les études de cas des clients.

Yann Chenu et David Hollick vous font un recap de ce talk 👇

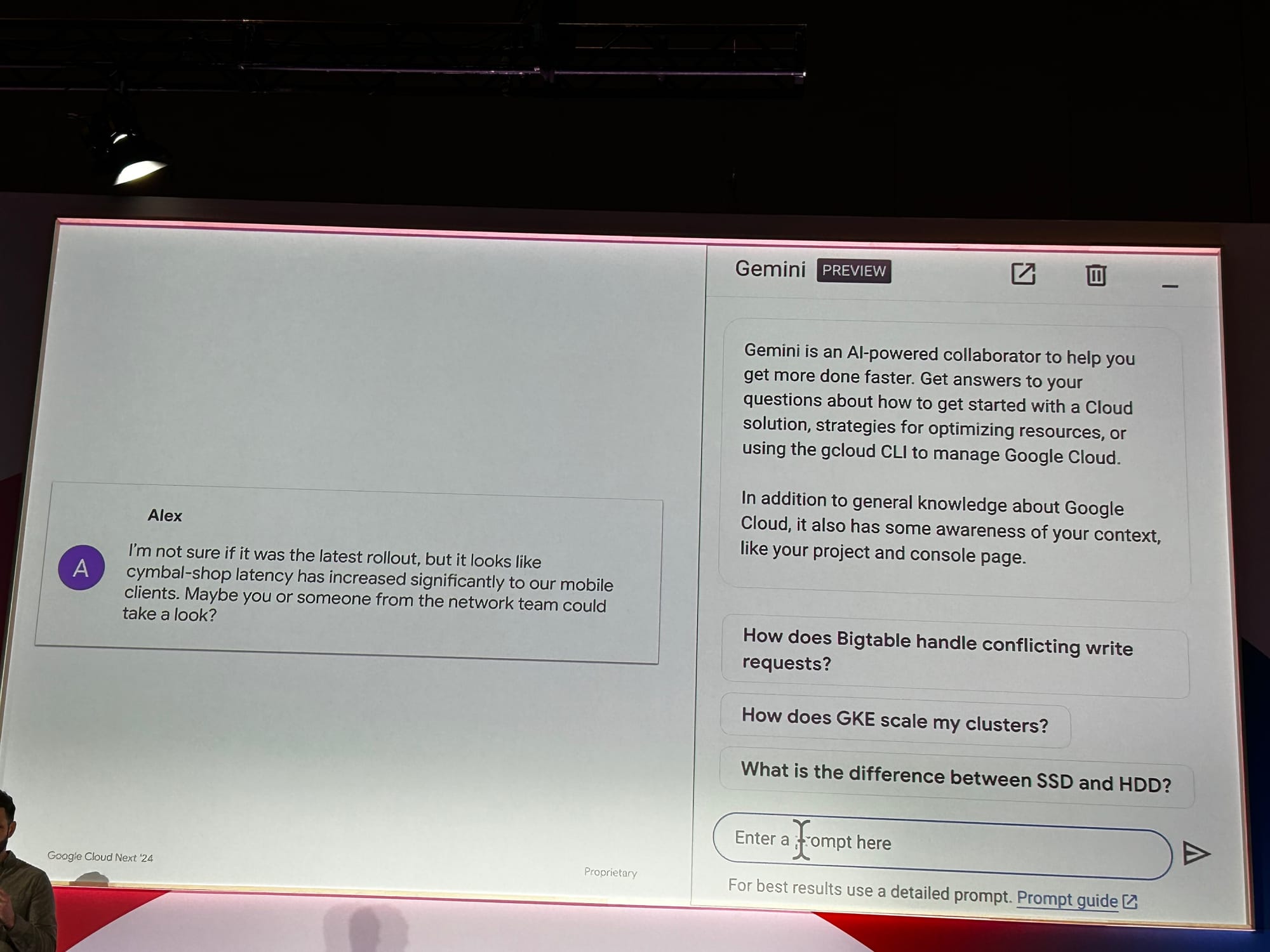

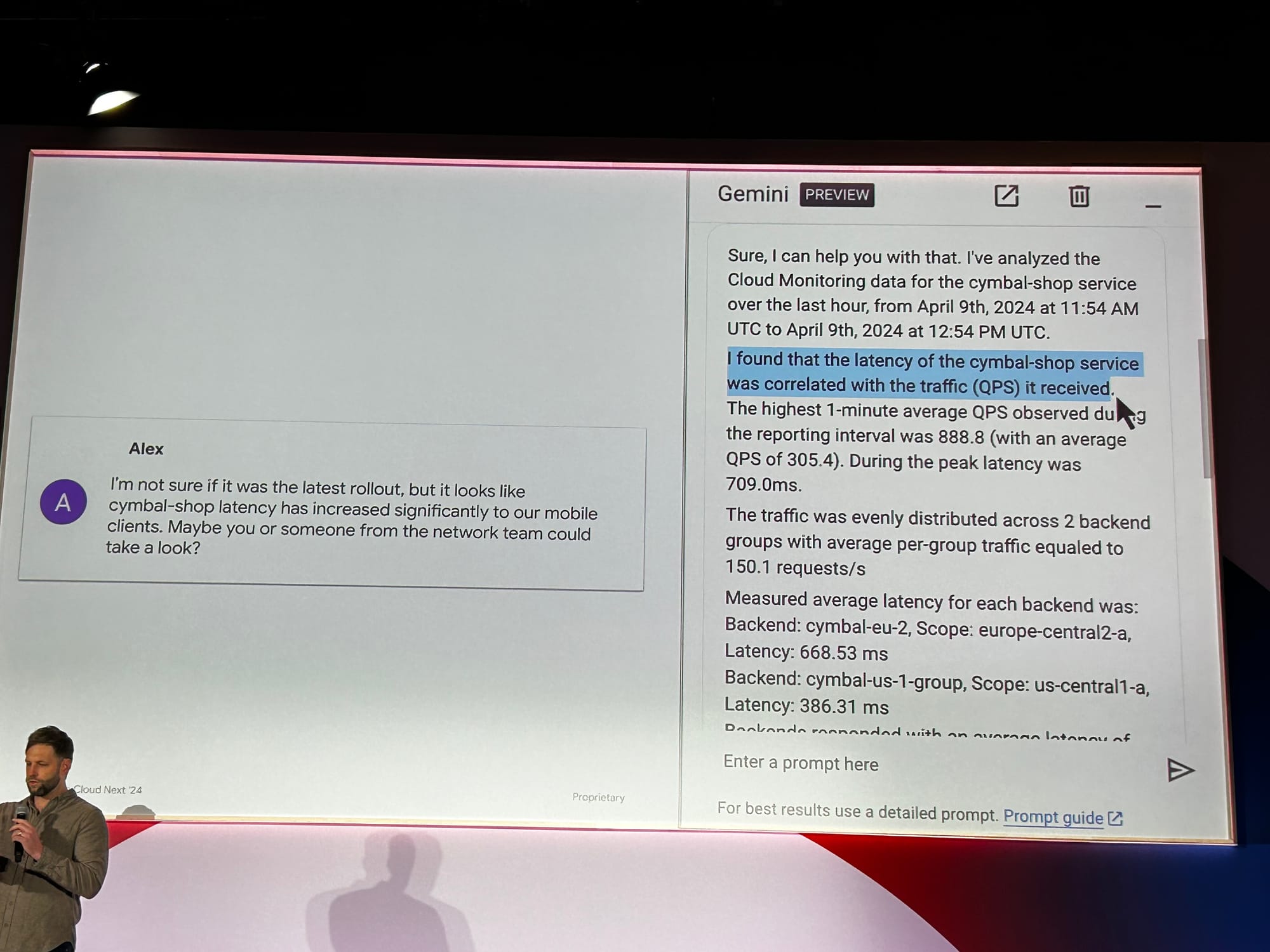

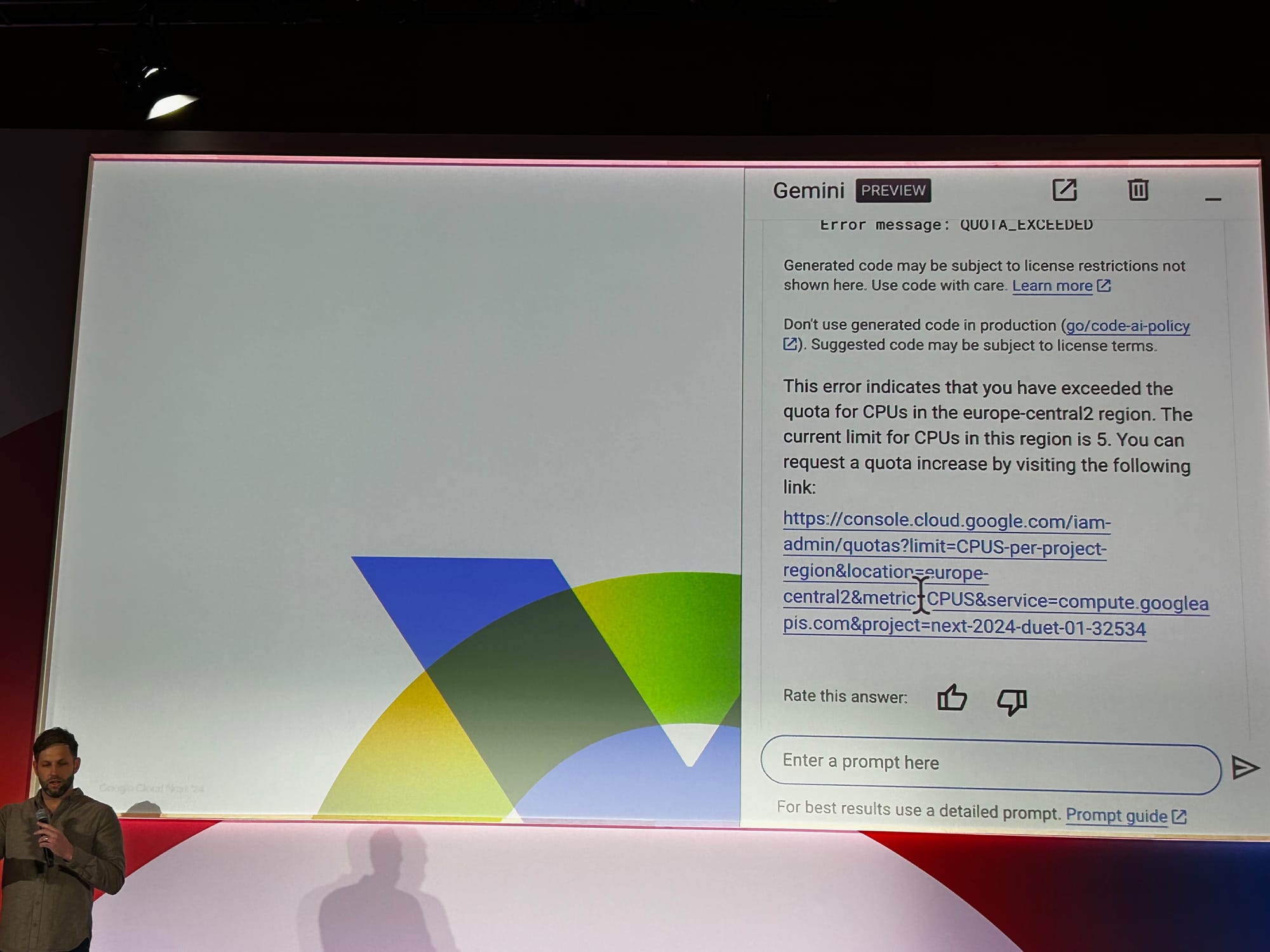

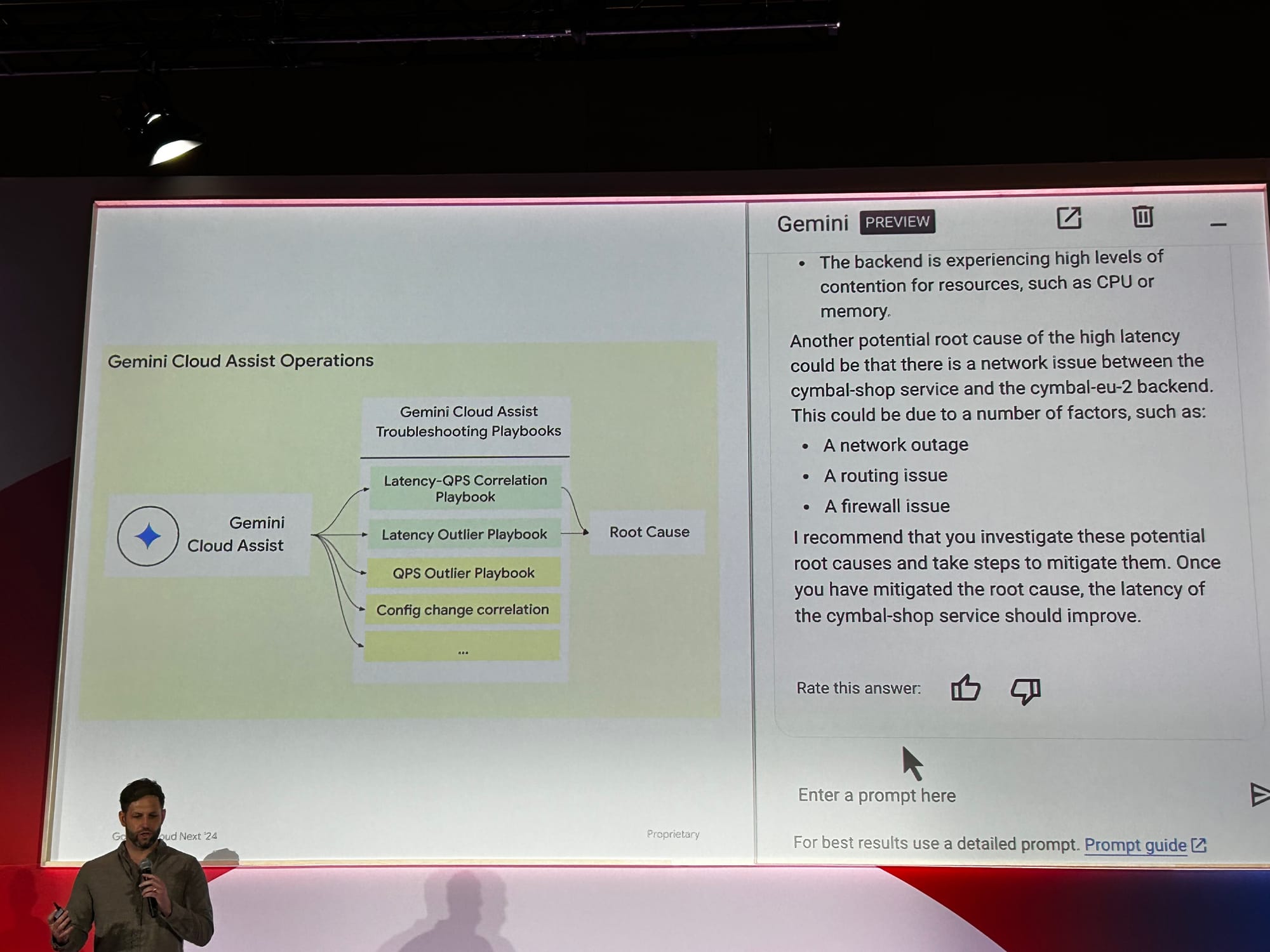

Troubleshooting les problèmes réseaux avec Gemini :

Ce talk a commencé par une démonstration de l’aide que pouvait apporter Gemini au niveau de l’analyse de problème réseau.

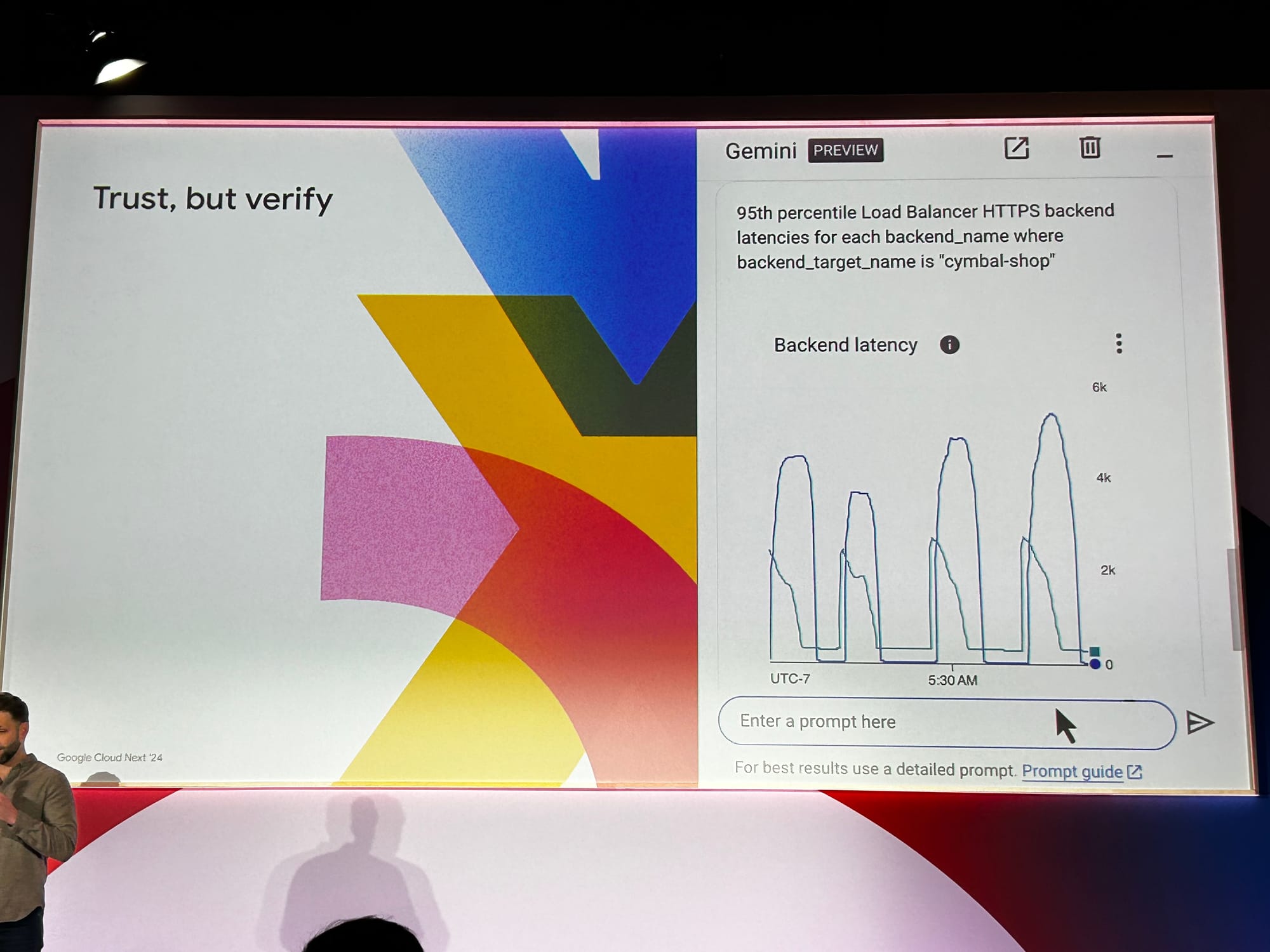

Partant d’un cas simple : si un utilisateur signale une latence inhabituelle dans l'application, il suffit de solliciter l’aide de Gemini via de simples questions en langage naturel comme “quelles seraient les causes de la latence de mon application ?” ou “montre-moi les percentiles à 95% de la latence de mes backends, classés par backend ?”. Gemini scanne l’infrastructure à la recherche d’informations et fournit des comptes rendus écrits ou sous forme de graphiques.

Au lieu de fouiller dans les logs ou d'espérer disposer d'un dashboard de monitoring adapté à notre problème spécifique, Gemini se charge de recueillir, synthétiser et présenter de façon cohérente les informations nécessaires à la résolution du problème rencontré. Dans le cas de la démonstration, un problème de quota insuffisant sur une région.

Gemini dispose de multiples playbooks afin de lui permettre de couvrir l'ensemble des problèmes rencontrés dans le cadre du réseau.

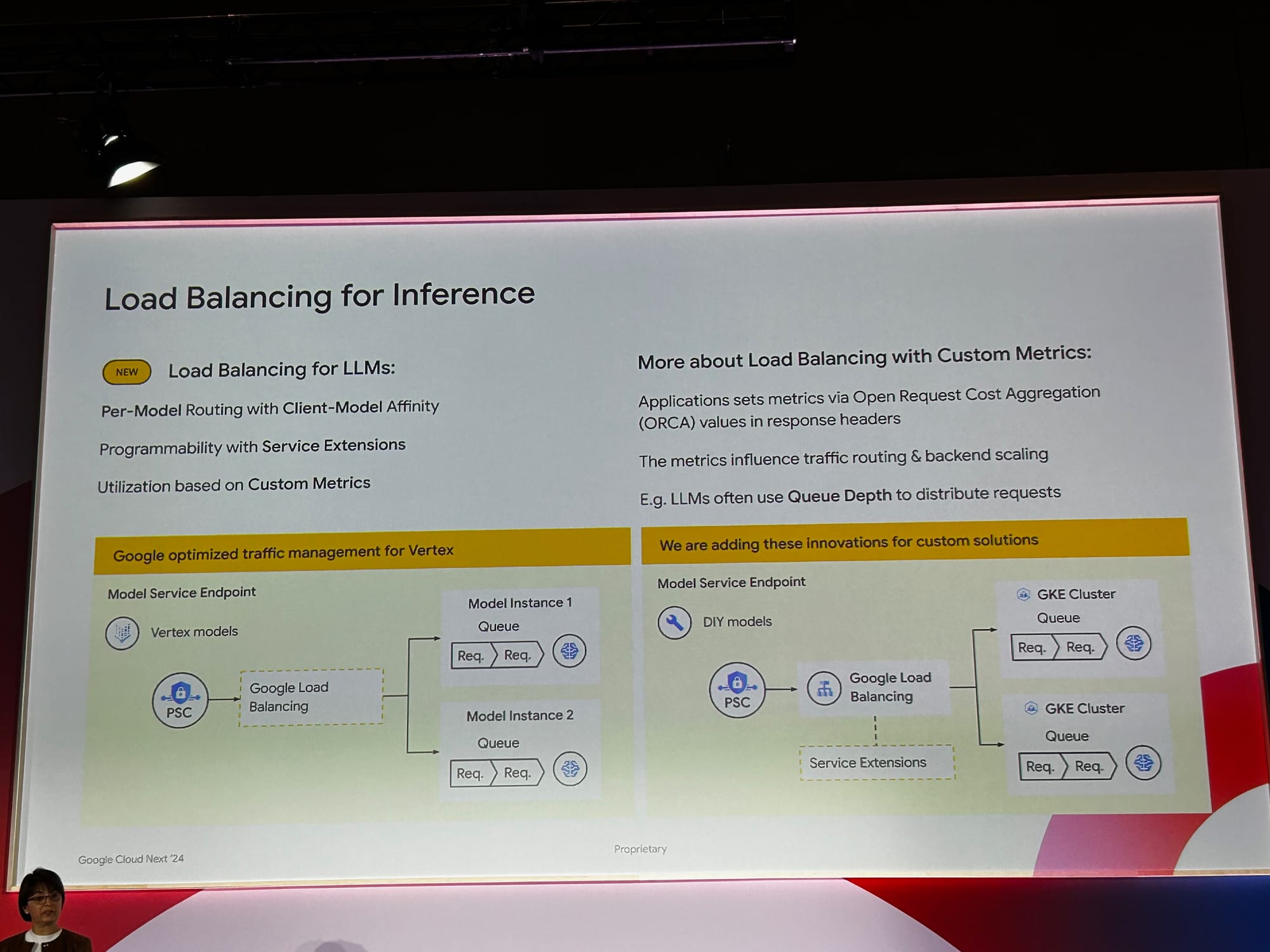

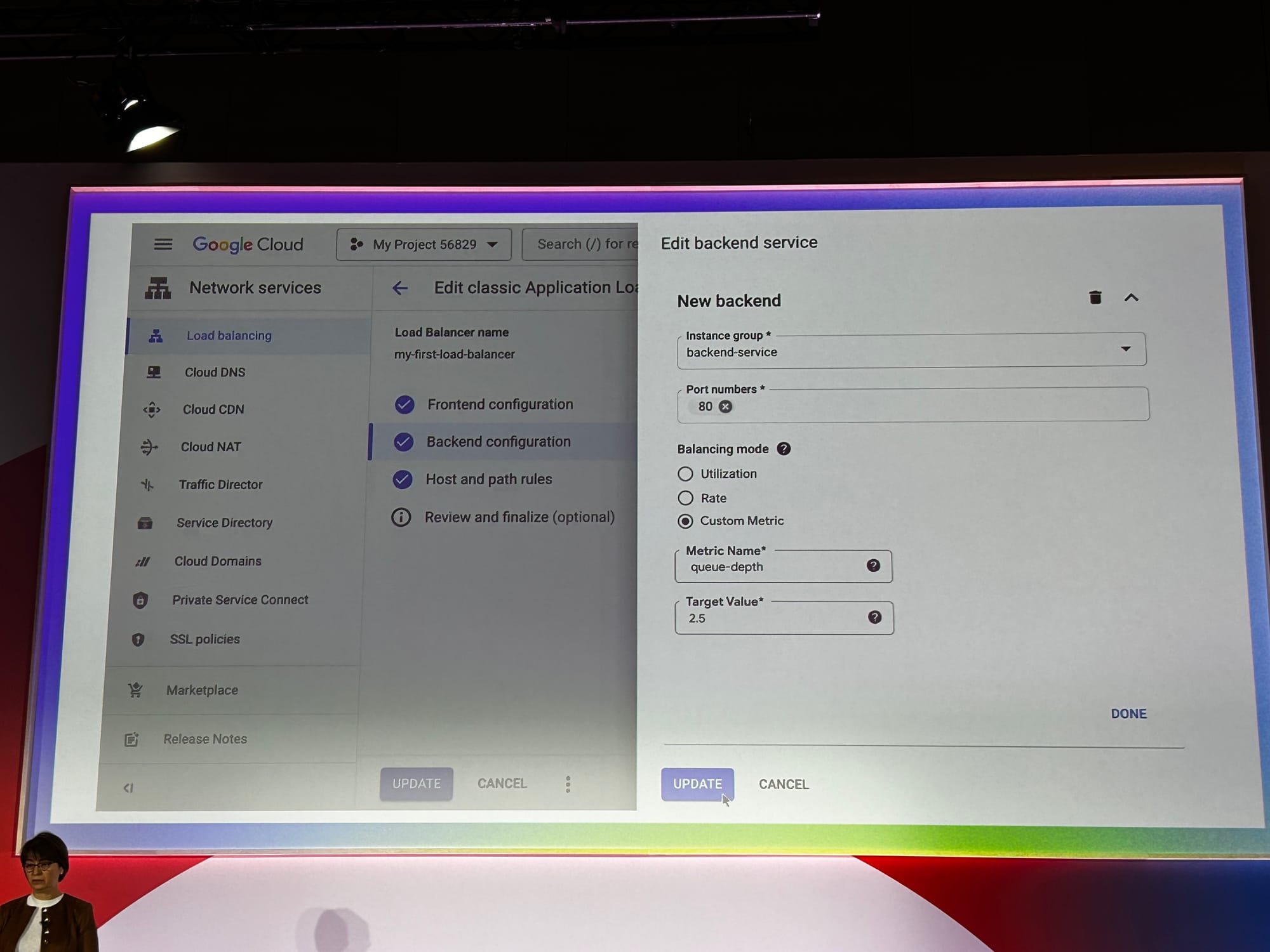

Load Balancing avec des Large Language Models (LLM)

Avec la naissance des LLMs et IA générative, il faut revoir les algorithmes des Load Balancers classiques qui sont basés sur le nombre de requêtes par secondes, ou l’utilisation CPU dans les backends. Un modèle LLM peut prendre potentiellement 100% des ressources TPU/GPU et chaque requête doit donc attendre que la requête en cours se termine avant qu’elle ne soit traitée. Il faut donc trouver un autre moyen pour que les load balancers puissent équilibrer la charge entre les backends LLMs .

Pour faire cela, Google a créé un custom métrique Queue Depth ou le nombre de requêtes en attente pour un LLM donné.

L’idée est assez simple. Au lieu de définir un nombre de requêtes par seconde ou l’utilisation du CPU dans le backend, on définit une profondeur cible basée sur le custom métrique Queue Depth. Il est déjà possible d’utiliser un custom métrique pour déterminer l'algorithme d'équilibrage de charge. Dans la photo suivante, on donne comme cible de profondeur 2,5 requêtes en attente sur un LLM

Traffic Routing pour les LLM

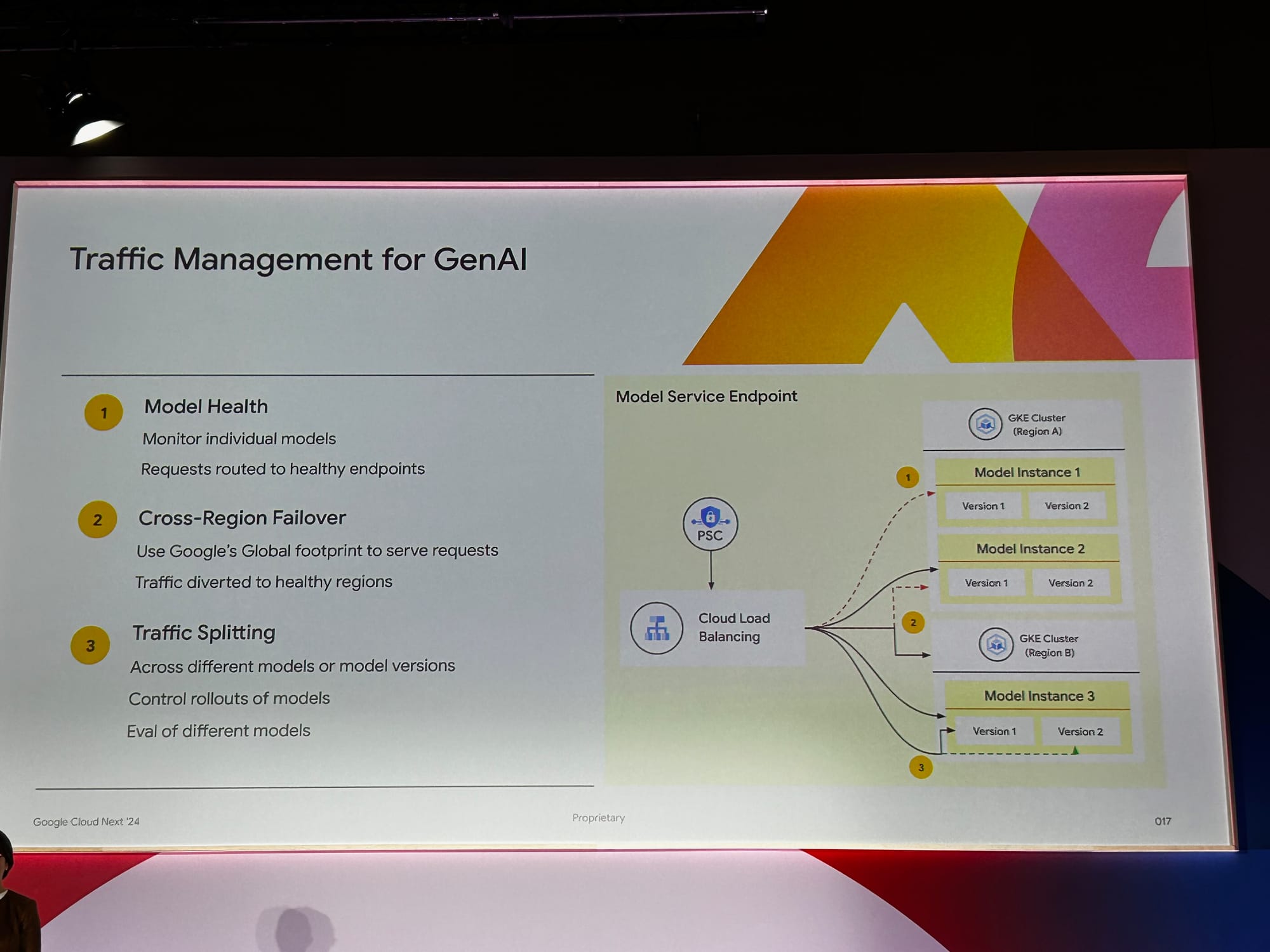

Comme avec les load balancers classiques il est possible d’implémenter le Traffic Routing pour les LLMs. Cette fonctionnalité comprend 3 points essentiels :

- Healthcheck du LLM - pour vérifier que le LLM est en état de recevoir du trafic

- Cross-Region Failover : Si jamais un LLM dans une région n’est plus disponible, un failover automatique vers un autre LLM dans une autre région est prévu

- Traffic Splitting : On peut implémenter du trafic splitting afin de tester une nouvelle version d’un LLM pour un déploiement de type Canary ou pour faire des A-B tests

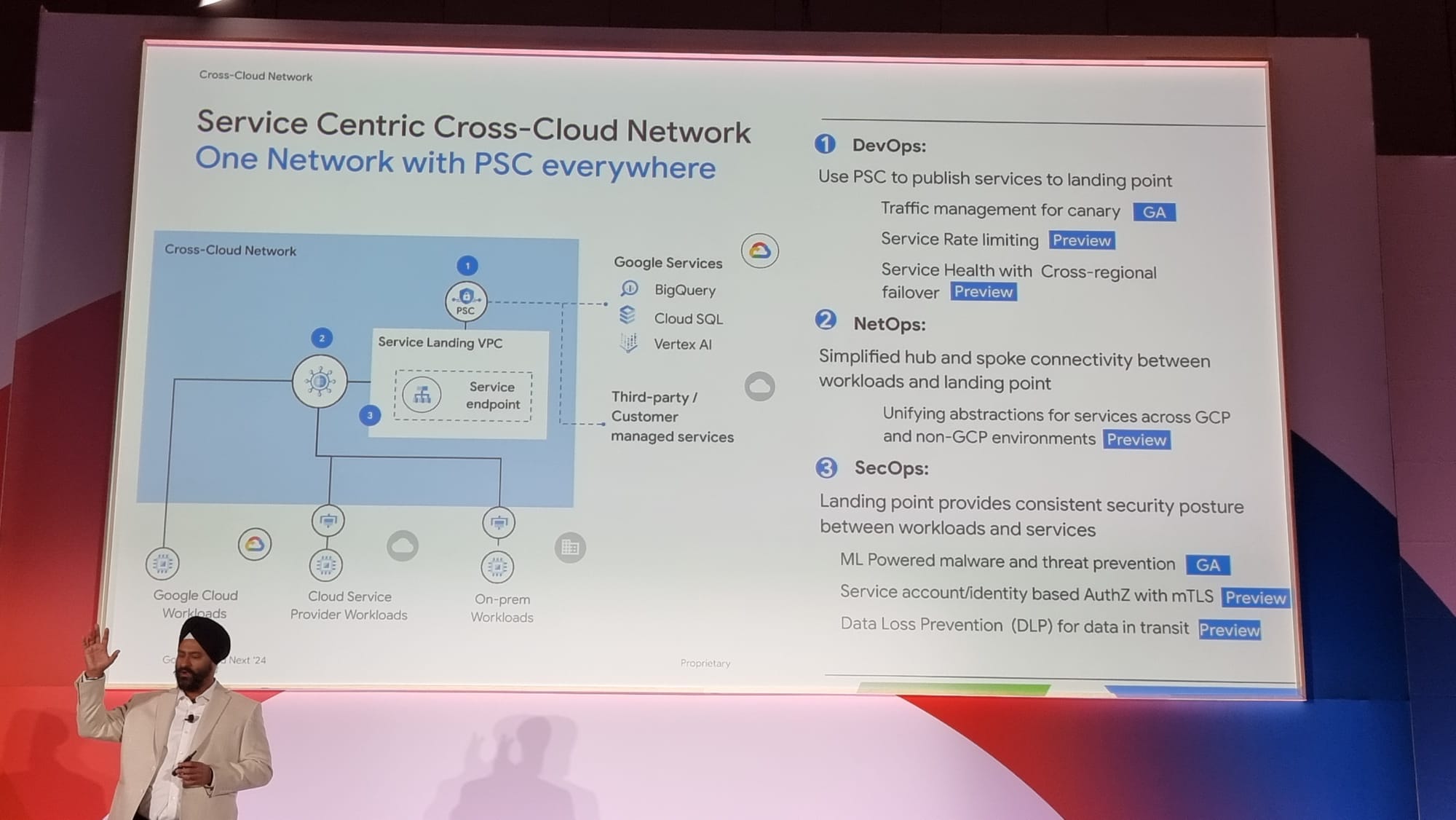

Service Centric Cross Cloud Network

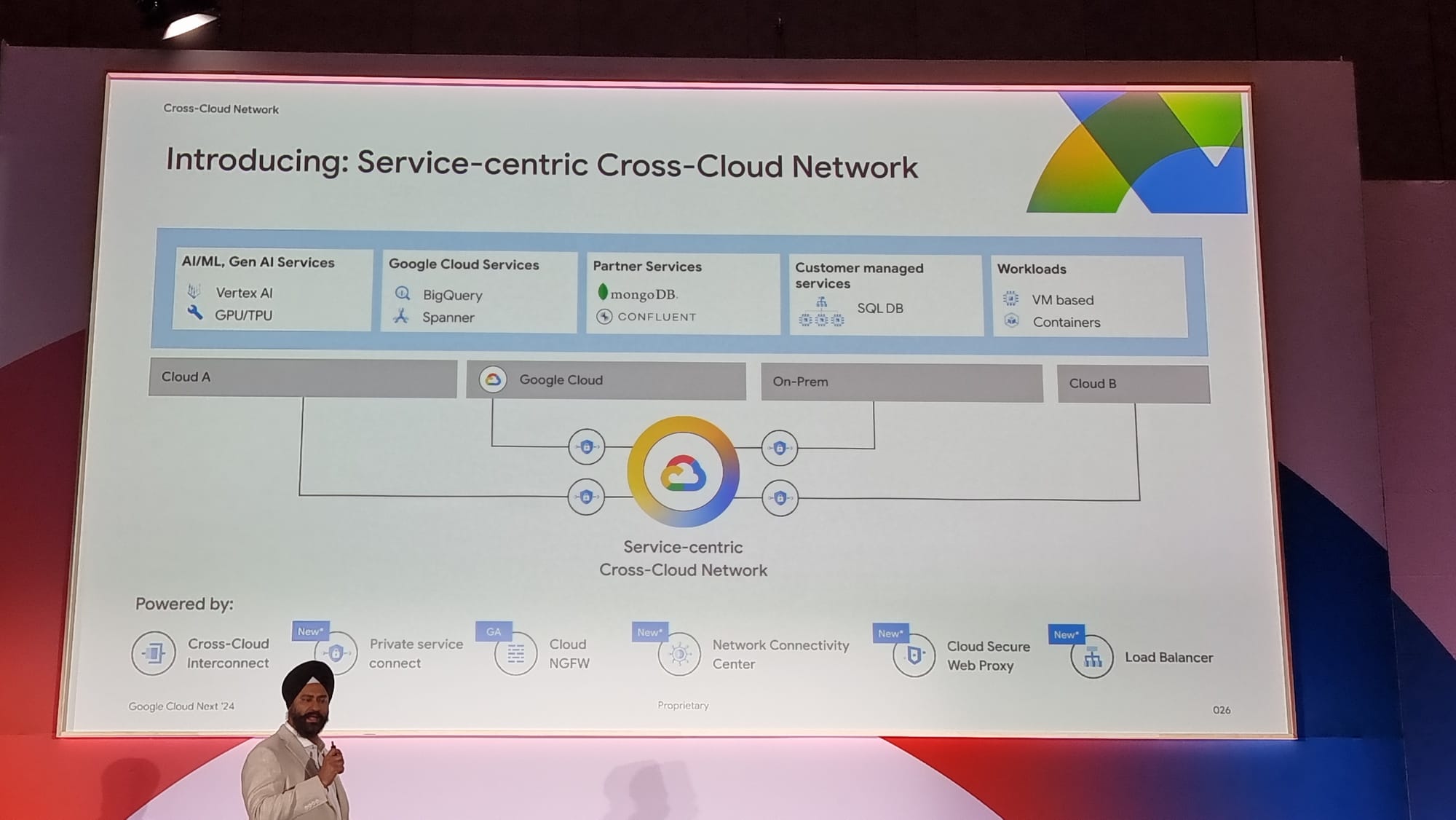

Dans la continuité de l’utilisation de LLM dans les fonctionnalités de routing et de load balancing, Google annonce un nouveau type de réseau : les Service-centric Cross Cloud network.

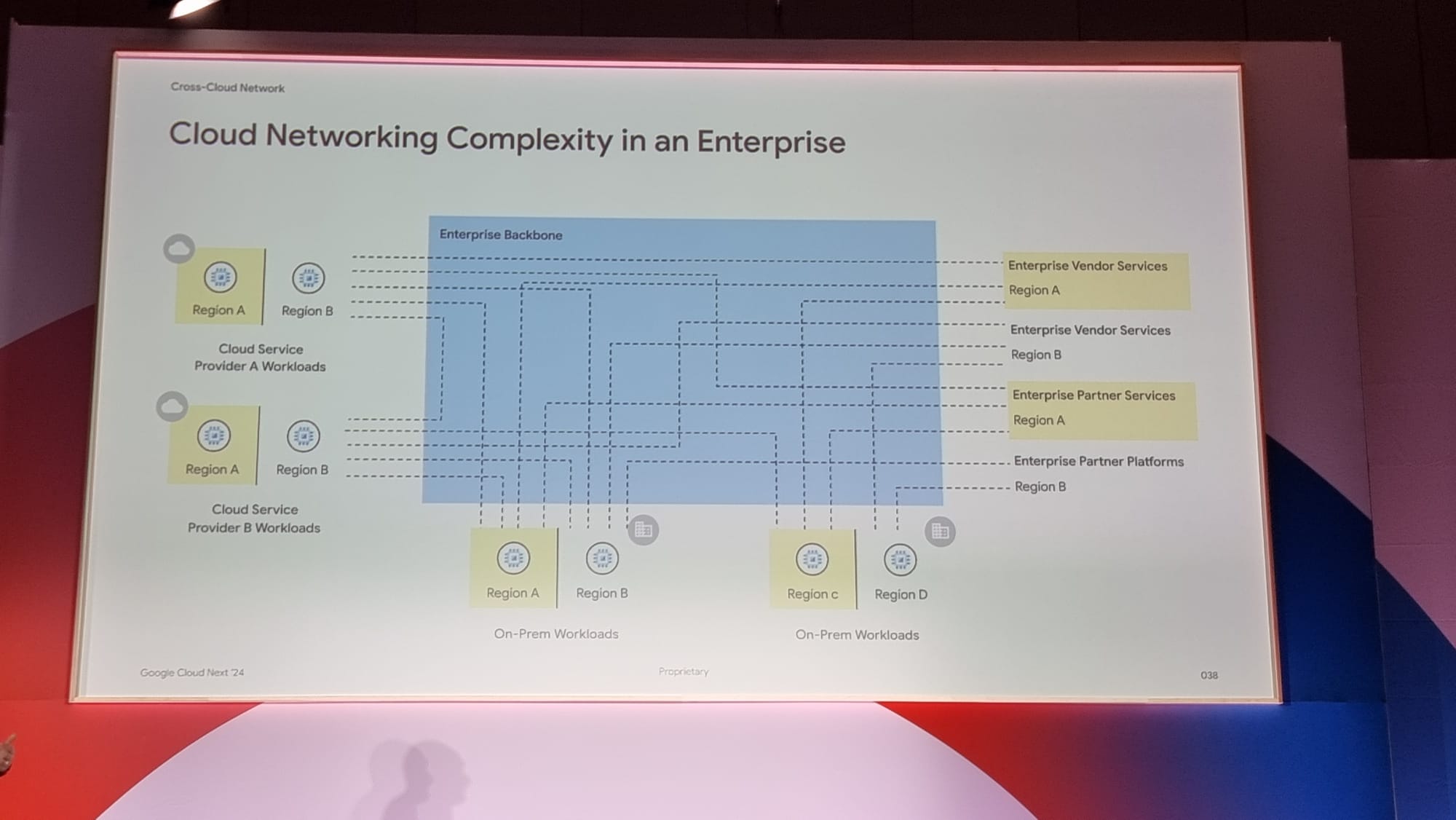

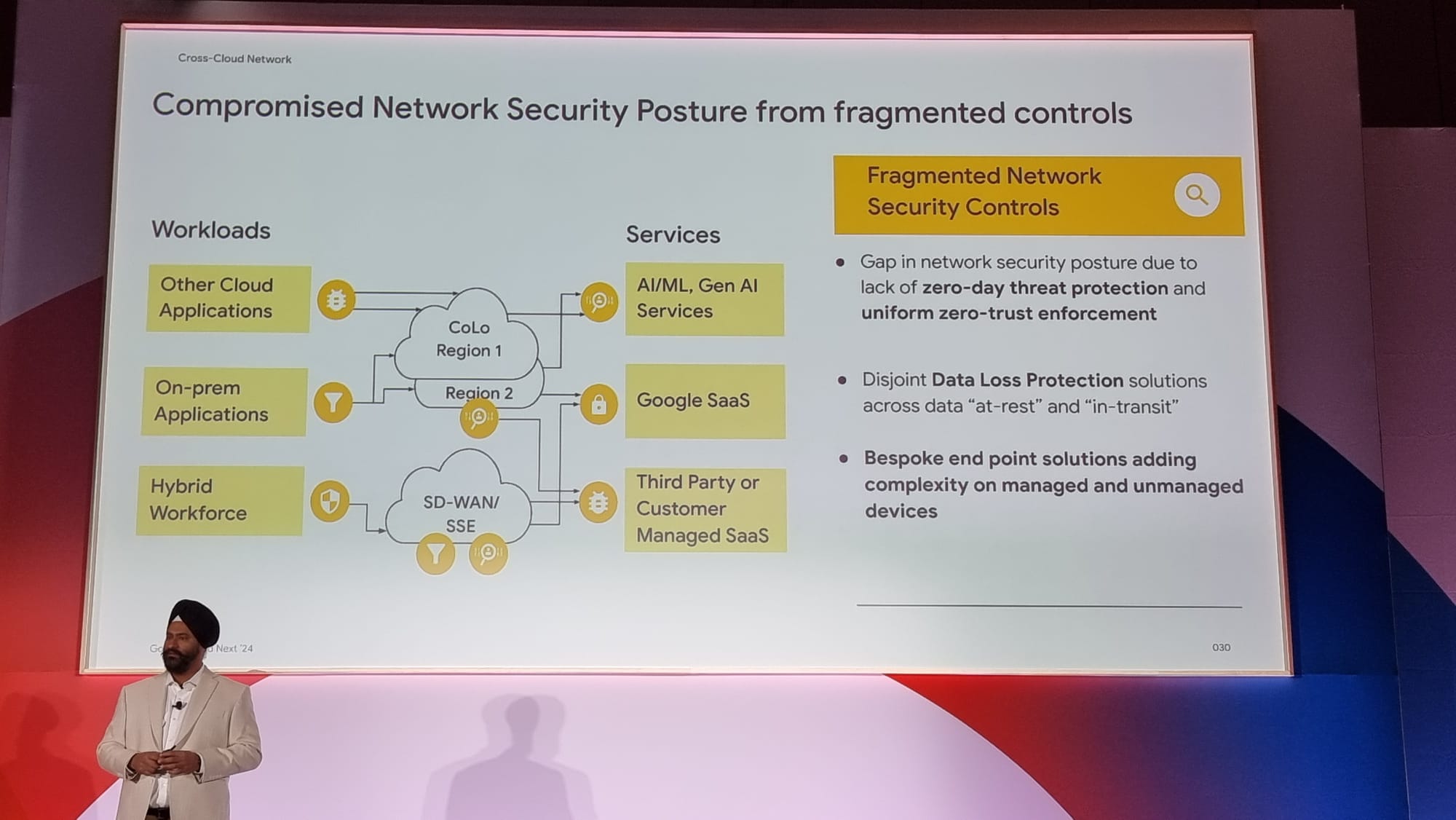

L'objectif est de réduire la complexité de l’architecture réseau traditionnelle comme on peut le voir ici :

en quelque chose de plus simple :

Ce type de réseau repose sur de multiples technologies, certaines existantes, certaines nouvelles :

- Cross-Cloud Interconnect

- Private Service Connect

- Cloud Next Gen FireWall

- Network Connectivity Center

- Cloud Secure Web Proxy

- Load Balancer

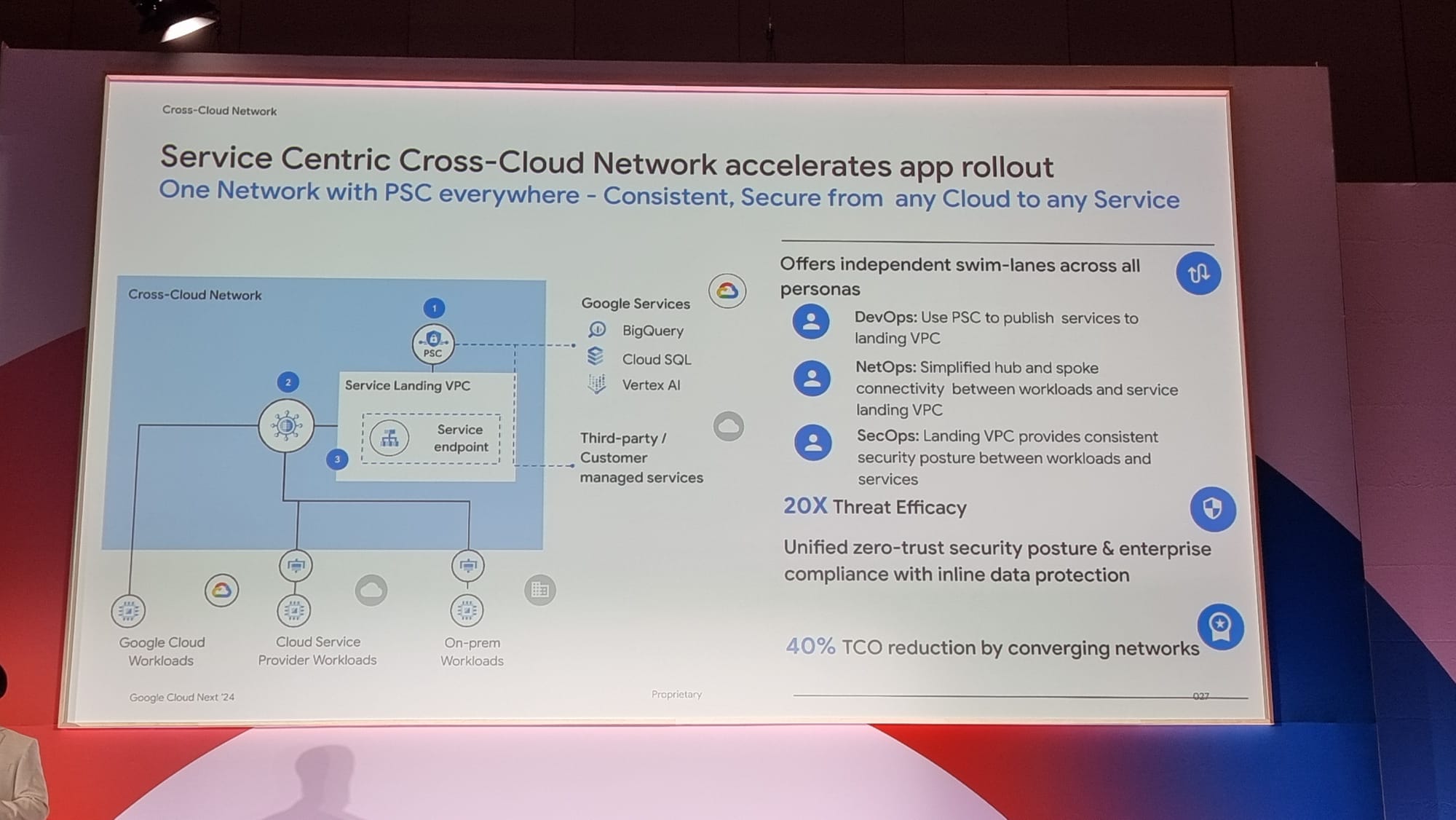

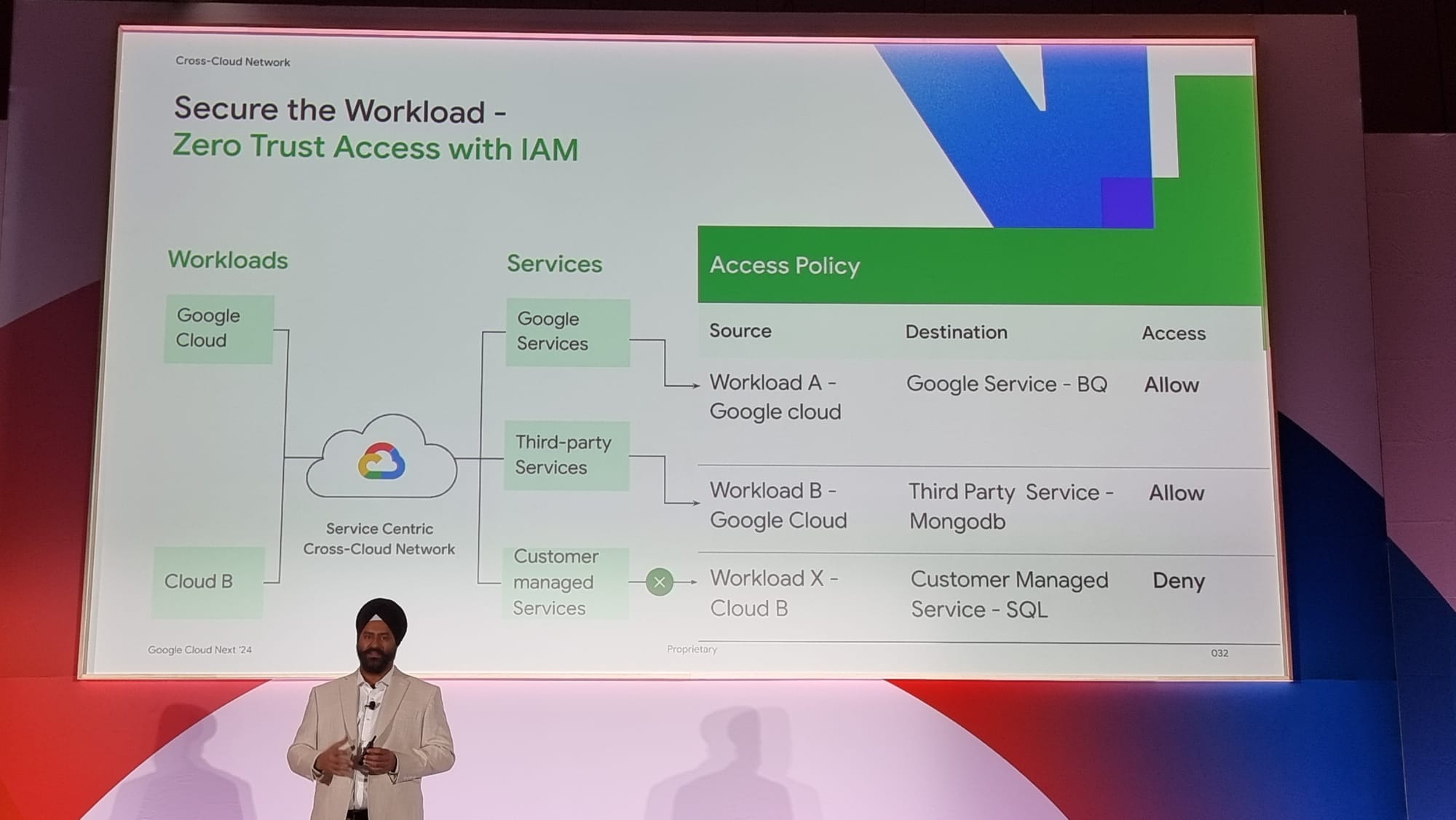

L’association de toutes ces technologies permet de construire un réseau “global” reliant Google Cloud, les datacenters on-premises, d’autres cloud providers,... Reposant massivement sur PSC, cela assure une communication aux différents services, que ce soit ceux de Google, ou d’autres partenaires / autres Clouds providers, de façon simplifiée tout en garantissant la sécurité.

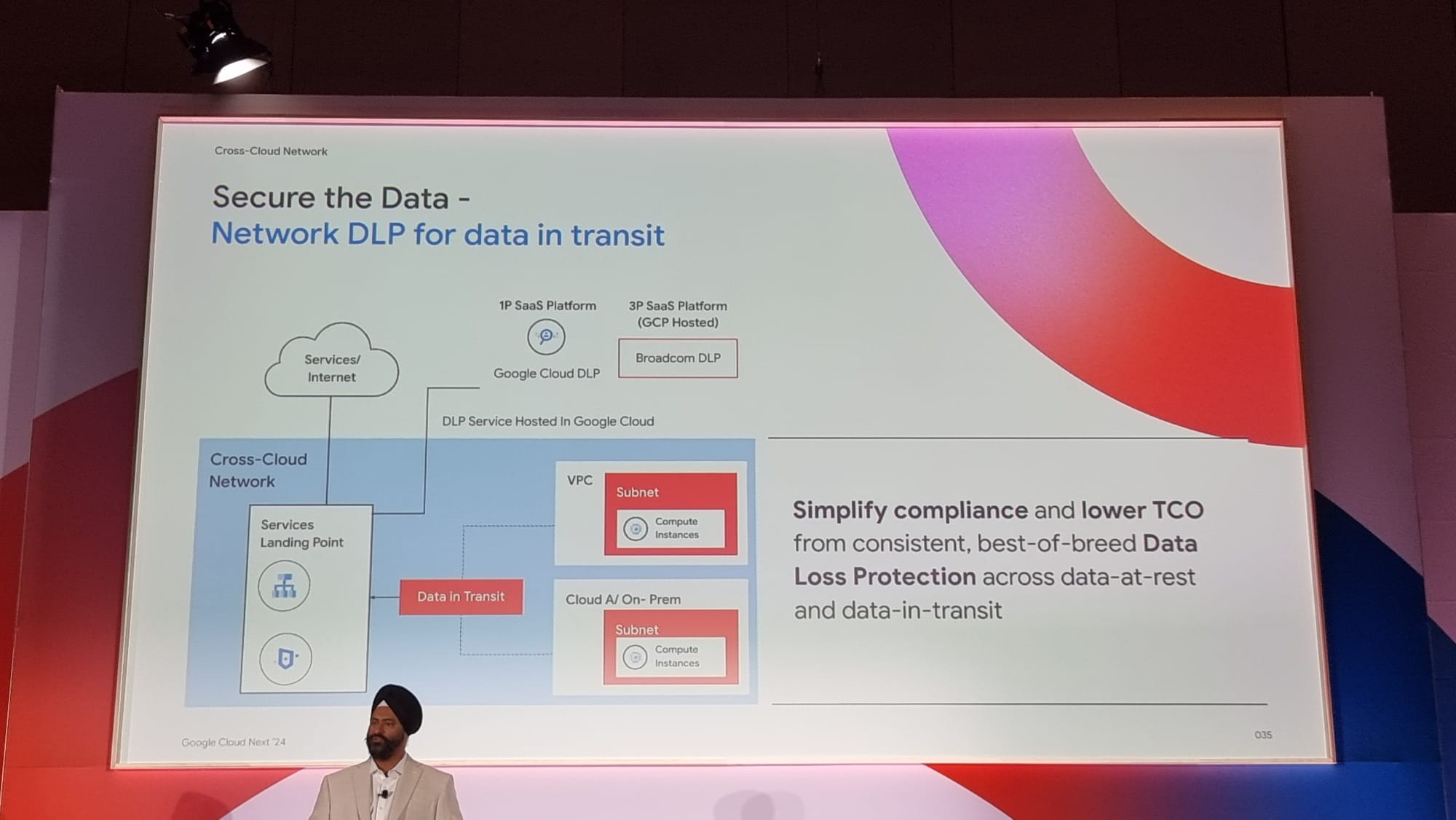

Un avantage est d’ensuite proposer des fonctionnalités comme du rate-limiting, un mode Canary pour le trafic vers les différents services, ou de pouvoir filtrer les données circulant sur le réseau via du DLP (que ce soit celui de Google ou celui d’un partenaire).

Un autre intérêt d’unifier les réseaux en un est de permettre d’améliorer la sécurité globale du réseau, en n’ayant à intervenir qu’à un seul endroit.

On peut gérer les flux facilement via des acces policies, permettant ainsi de réguler l’accès aux différents services présents sur le réseau.

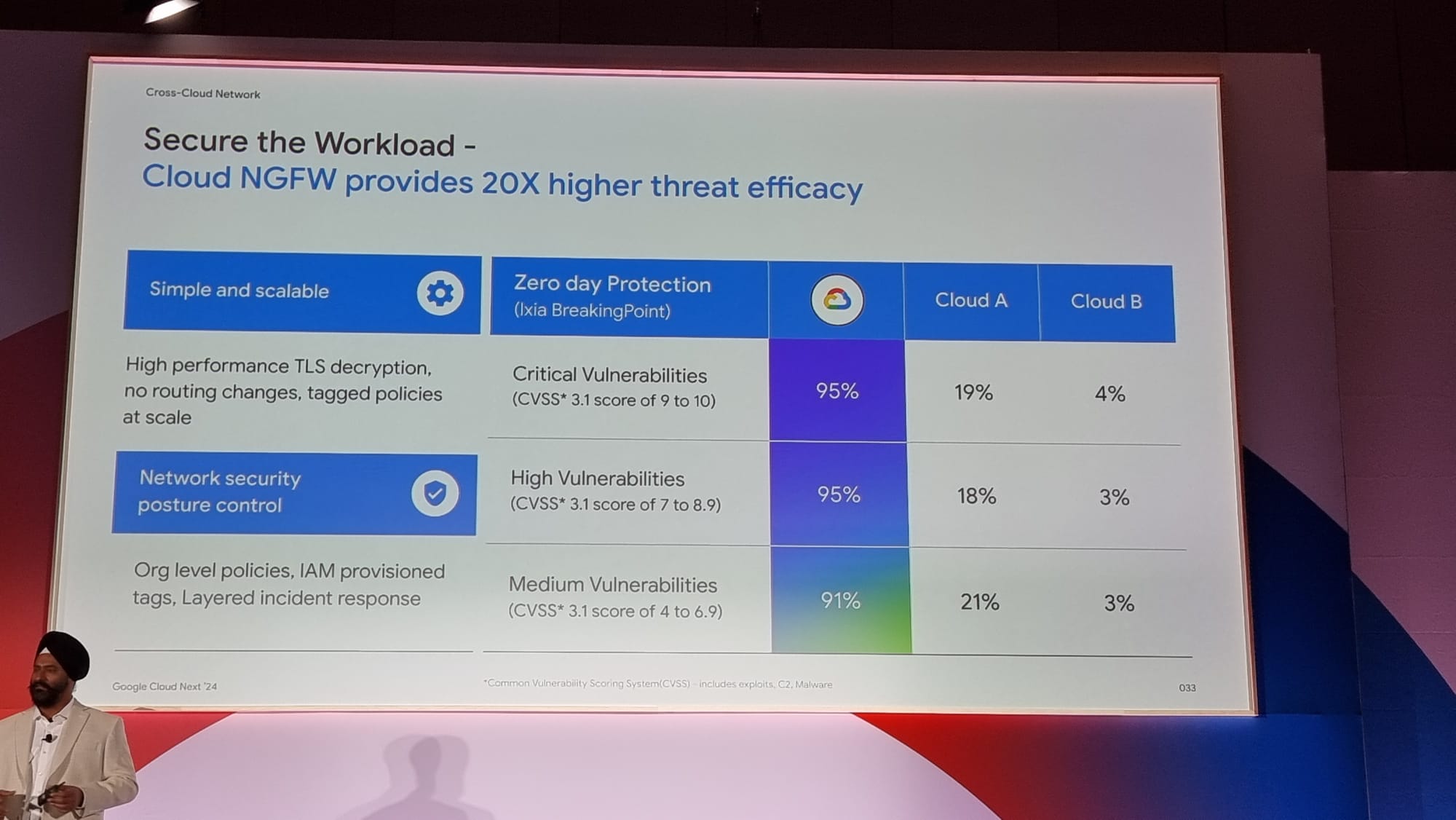

Via l’utilisation de Cloud NGFW, les flux circulants sur le réseau peuvent être filtrés facilement, sans avoir besoin d’ajouter des appliances de sécurité comme Palo Alto ou Fortinet, ce qui permet de garder une infrastructure simple.

Un défi d’un tel réseau est qu’une énorme quantité de données circulent dessus. Et potentiellement certaines de ces données ne devraient pas y être. D’où l’intégration de Cloud DLP ou d’un autre DLP d’un partenaire offrant la possibilité de filtrer ces données.

Use-Case Scotiabank

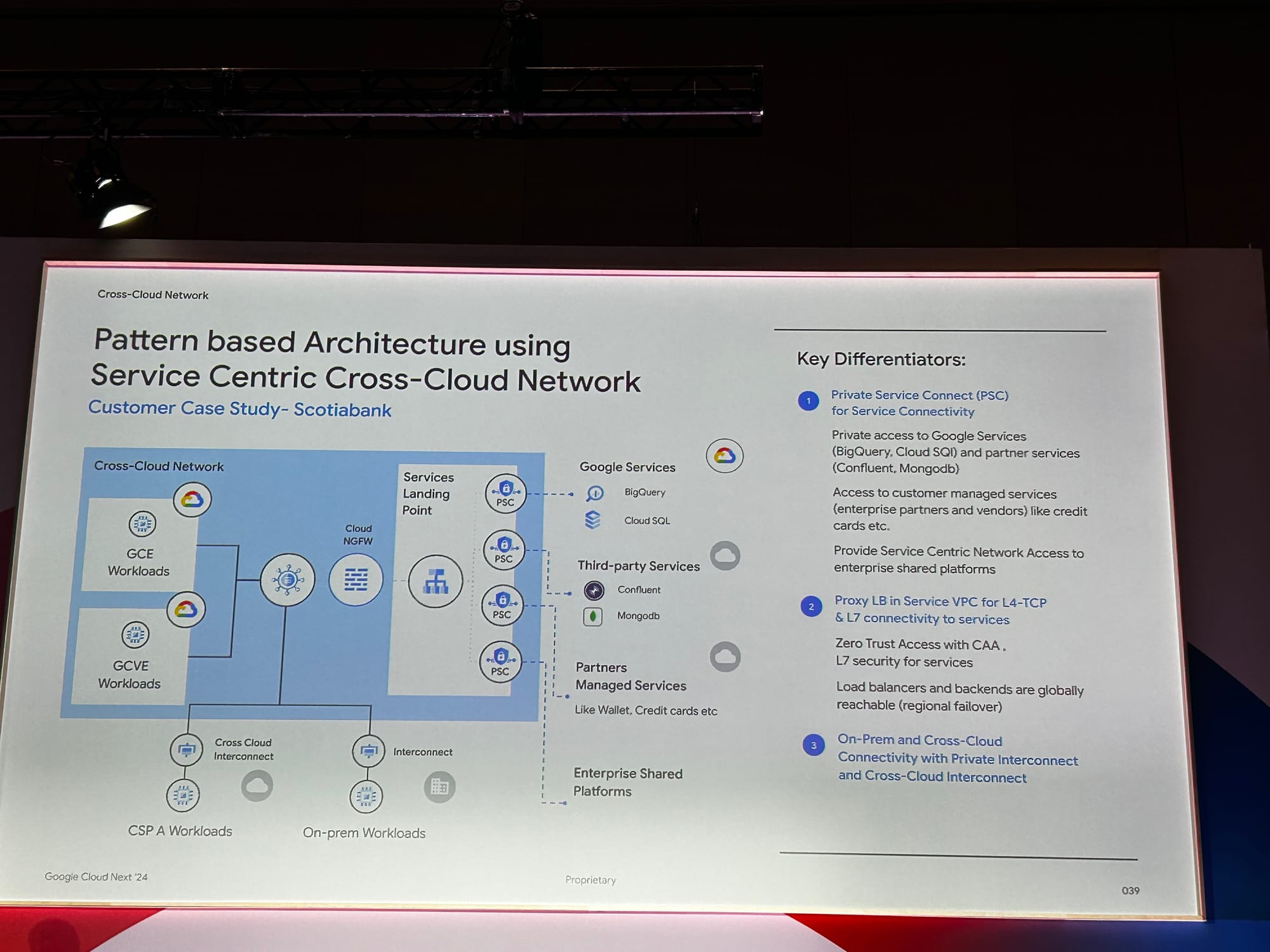

Pour finir cette session passionnante des nouvelles fonctionnalités réseau, Payam Kohan de la société Scotiabank nous a présenté leur implémentation du Service Centric Cross Cloud Network

Cette solution permet d’intégrer

- un deuxième provider cloud, les workloads on premise,

- des workloads Google Cloud, des services Google, des services tierces tels que MongoDB et Confluent,

- des services de leurs partenaires

- des services des hébergés sur leur plateforme d’entreprise

Cette solution s’appuie sur un VPC Landing Services Point, une interconnexion Cross Cloud et une interconnexion vers l’on premise. Les différents services sont intégrés dans le Landing Services Point via des Private Services Connect endpoints.

Afin de sécuriser et filtrer les différents flux réseaux Scotiabank utilise un Cloud Next Generation Firewall (Cloud NGFW)

Conclusion

Avec le réseau Cross-Cloud, Google offre la possibilité de simplifier, moderniser et sécuriser votre architecture réseau hybride et multicloud. Grâce aux progrès de l'intelligence artificielle, vous pouvez exploiter ce réseau pour transférer vos données où vous le souhaitez, afin de les utiliser pour la formation et l'inférence sur Google Cloud.