Imaginez une immense bibliothèque où des milliards de livres sont empilés un peu partout. Si vous vouliez trouver toutes les phrases contenant un certain mot, il vous faudrait des années à chercher page par page, livre par livre. Apache Spark, c'est comme engager une armée de bibliothécaires ultra-rapides qui, chacun avec une portion des livres, pourraient trouver toutes les occurrences de ce mot en quelques minutes, en communiquant et en partageant les résultats instantanément. C'est ça la puissance de cette définition : un "super-ordinateur" virtuel capable de traiter des quantités astronomiques de données à une vitesse fulgurante.

Définition de "Apache Spark"

Apache Spark est un moteur d'analyse unifié et open source conçu pour le traitement des données à très grande échelle. Né d'un projet de recherche à l'université de Californie à Berkeley par AMPLab en 2009, son code a été par la suite donné à la Fondation Apache, qui en assure désormais la maintenance et le développement. La définition principale d'Apache Spark réside dans sa capacité à offrir un cadre de calcul distribué, permettant de programmer des clusters avec un parallélisme de données implicite et une tolérance aux pannes.

Ce framework se distingue notamment par sa rapidité exceptionnelle, étant bien plus véloce que son prédécesseur, Hadoop MapReduce, grâce à son traitement en mémoire. Il peut être jusqu'à cent fois plus rapide pour le traitement en mémoire et dix fois plus rapide pour le traitement sur disque. Cette prouesse est rendue possible par les Resilient Distributed Datasets (RDDs), l'abstraction fondamentale de Spark. Les RDDs permettent de stocker les données en mémoire entre les différentes étapes de calcul, évitant ainsi les coûteuses écritures/lectures sur disque nécessaires à MapReduce pour chaque opération. Cette approche rend Spark idéal pour les applications itératives comme le Machine Learning ou les analyses interactives. Toutefois, pour des ensembles de données si massifs qu'ils ne tiendraient pas en mémoire, MapReduce, bien que plus lent, pourrait toujours être une option viable en s'appuyant sur le stockage disque.

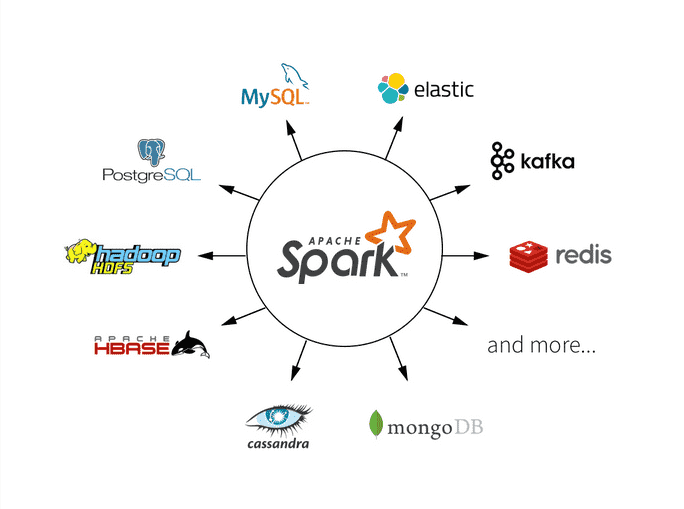

L'Écosystème Riche et Modulaire de Spark

Apache Spark est devenu un pilier pour les charges de travail du Big Data et du Machine Learning, capable d'effectuer des analyses complexes à grande échelle. La définition d'Apache Spark s'étend à un écosystème riche et modulaire, incluant plusieurs bibliothèques clés qui peuvent être utilisées ensemble pour diverses applications :

- Spark SQL : Permet aux utilisateurs d'interroger des données structurées et semi-structurées en utilisant le langage SQL standard. Il optimise les requêtes sur des volumes importants de données.

- Spark Streaming : Offre la possibilité de traiter des données en flux, en temps réel, pour des analyses continues. Il est essentiel pour les applications nécessitant une réactivité immédiate.

- MLlib (Machine Learning Library) : Une bibliothèque d'apprentissage automatique qui facilite la construction et l'application d'algorithmes de Machine Learning sur des ensembles de données distribués. Elle inclut des algorithmes pour la classification, la régression, le clustering, etc.

- GraphX : Une API pour le traitement de graphes et le calcul de graphes distribués, permettant d'analyser des relations complexes entre les données (par exemple, réseaux sociaux, systèmes de recommandation).

Flexibilité et Accessibilité

Apache Spark est polyvalent et peut être déployé sur Apache Hadoop, Kubernetes, de manière autonome, ou dans le cloud (via des services comme AWS, Azure, Google Cloud), s'adaptant à de nombreuses sources de données. Il fournit des API riches en Scala, Java, Python (notamment PySpark) et R, le rendant accessible à un large éventail de développeurs et de data scientists. Cette définition de Spark en fait un outil fondamental pour les entreprises qui cherchent à transformer, nettoyer et agréger d'énormes volumes d'informations.

Considérations et Défis

Malgré ses nombreux avantages, il est important de noter certains aspects de Spark :

- Consommation de Mémoire : Bien que sa vitesse provienne du traitement en mémoire, cela signifie que des jeux de données très volumineux peuvent nécessiter des configurations matérielles coûteuses avec beaucoup de RAM. Des erreurs de type "Out-of-Memory" peuvent survenir si l'application n'est pas optimisée.

- Complexité du Débogage et de la Configuration : En tant que système distribué, le débogage des applications Spark et l'optimisation de ses nombreux paramètres peuvent être complexes et nécessitent une expertise pour obtenir les meilleures performances.

En somme, la définition d'Apache Spark va bien au-delà d'un simple outil de traitement : c'est une plateforme d'analyse unifiée, puissante et flexible, essentielle pour naviguer et exploiter les volumes croissants de données dans le monde d'aujourd'hui. Sa capacité à unifier diverses charges de travail analytiques en fait un choix privilégié pour les architectures Big Data modernes.