Introduction

Semaine du 2 au 5 février 2026. En trois jours, Anthropic et OpenAI ont lâché leurs plus grosses mises à jour en simultané. Le genre de semaine qui redéfinit ce que "coder avec l'IA" veut dire !

Au programme :

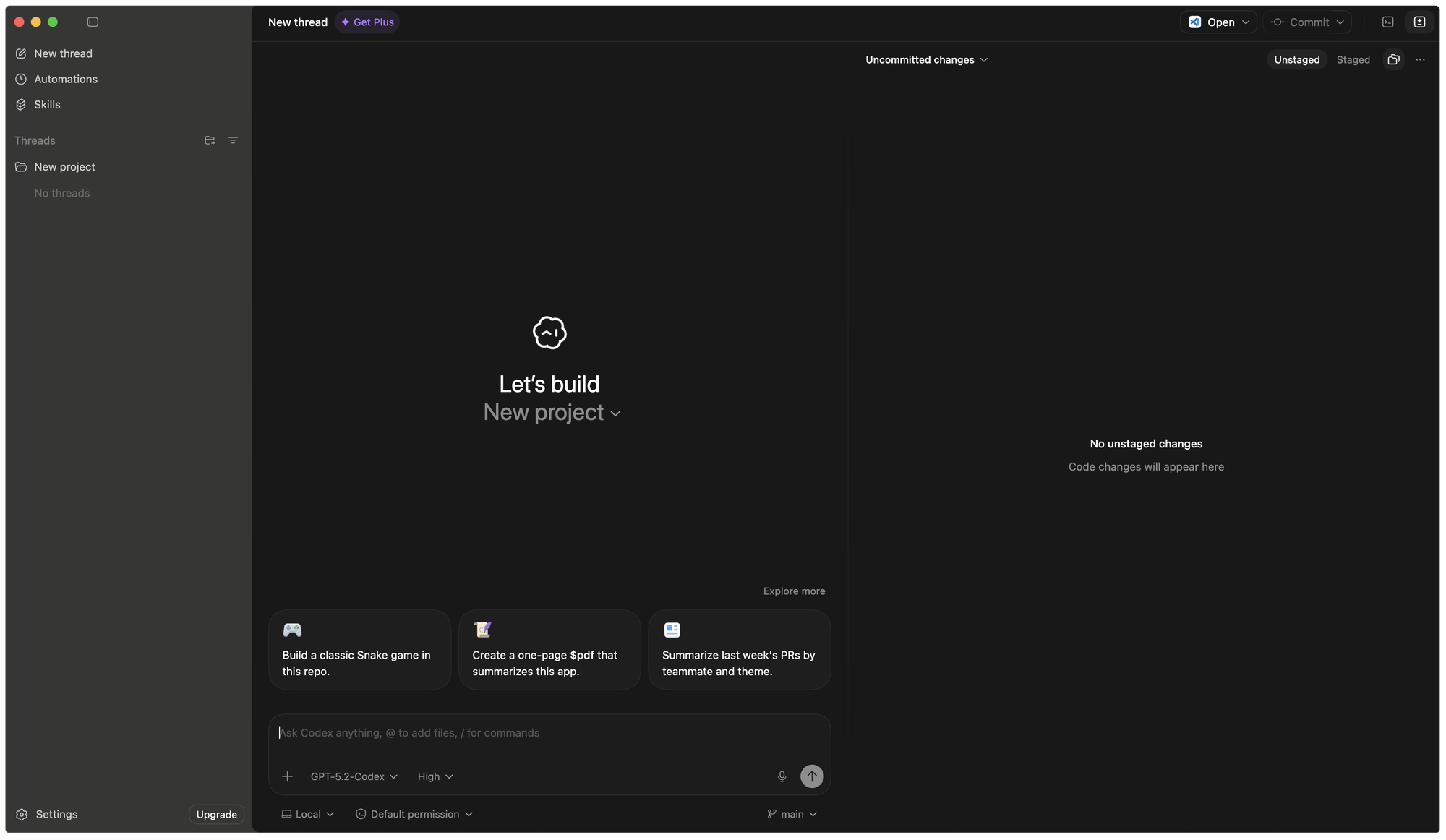

- L'app macOS Codex d'OpenAI (2 février)

- Claude Opus 4.6 d'Anthropic (5 février)

- GPT-5.3-Codex d'OpenAI (5 février)

On fait le tour, on compare, et on vous dit ce qu'il faut retenir.

L'app macOS Codex : OpenAI dégaine en premier (2 février)

OpenAI ouvre le bal avec une app macOS standalone dédiée au coding. L'idée : un centre de commande pour gérer plusieurs agents en parallèle sur des tâches longues.

Concrètement, c'est une interface qui vous permet de lancer des agents Codex sur différentes parties de votre codebase en même temps — frontend, backend, tests — sans jongler entre les fenêtres.

Le truc à retenir : l'app est temporairement gratuite pour les forfaits Free et Go de ChatGPT. Sam Altman parle d'environ deux mois. Les forfaits payants (Plus, Pro, Business) voient leurs rate limits doublés pendant cette période.

Claude Opus 4.6 (5 février)

Anthropic sort son nouveau flagship. Trois nouveautés changent la donne 🤩 :

- 1M de tokens de contexte. La fenêtre de contexte passe de 200K à 1M tokens (en bêta). En pratique, vous pouvez charger une codebase entière dans une seule conversation. Sur le benchmark MRCR v2 (test de retrouver une info dans un contexte long), Opus 4.6 score 76% contre 18.5% pour Sonnet 4.5.

- Agent Teams. Plusieurs instances de Claude bossent en parallèle sur un même projet, sans intervention humaine. La démo d'Anthropic parle d'elle-même : 16 agents ont construit un compilateur C en Rust en 2 semaines. 100 000 lignes de code, capable de compiler le kernel Linux sur x86, ARM et RISC-V. Coût total : ~20 000 $ en API.

- Adaptive Thinking. Fini la configuration manuelle du "budget de réflexion". Le modèle ajuste automatiquement son effort selon la complexité de la tâche, avec quatre niveaux (low, medium, high, max).

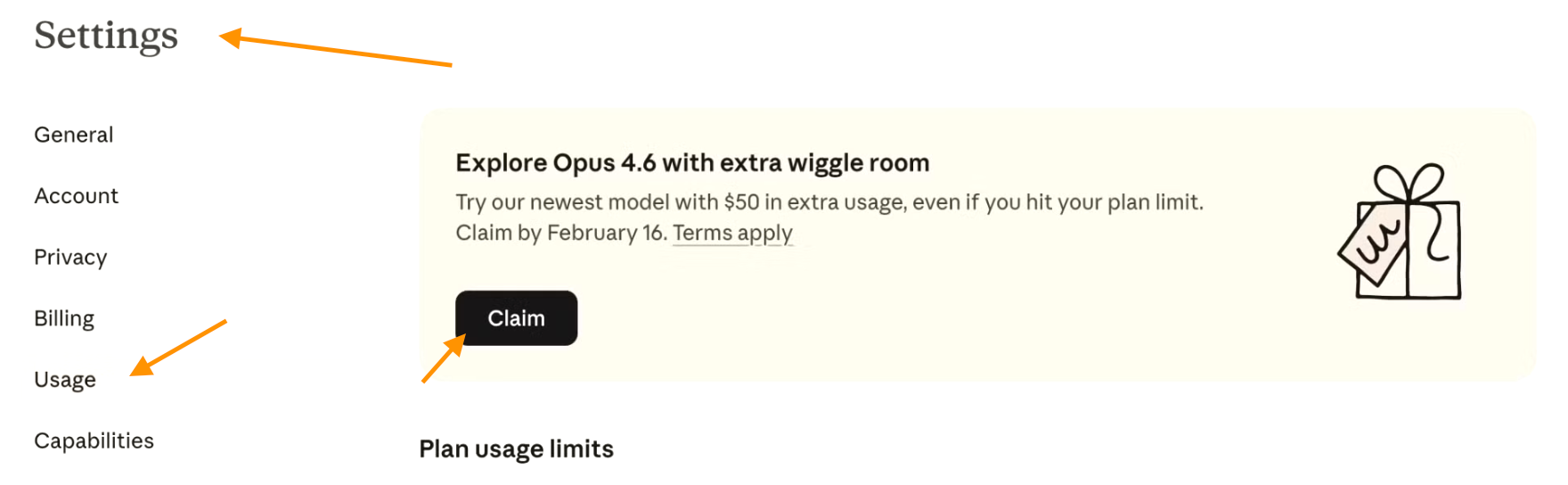

À savoir : si vous êtes abonné Pro ou Max avant le 5 février, vous pouvez récupérer 50 $ de crédits Extra Usage pour tester Opus 4.6. Il suffit d'activer l'option avant le 16 février — les crédits expirent 60

jours après. Pensez à désactiver Extra Usage ensuite pour éviter les mauvaises surprises.

GPT-5.3-Codex (5 février)

Le même jour, OpenAI riposte avec un modèle agentic spécialisé coding. Trois points marquants.

25% plus rapide. GPT-5.3-Codex est nettement plus rapide que son prédécesseur (GPT-5.2-Codex) grâce à des améliorations d'infrastructure, sans compromis sur la qualité du code.

Premier modèle à avoir participé à sa propre création. OpenAI le dit clairement : des versions intermédiaires de GPT-5.3 ont servi au debugging du training, à la gestion du déploiement et aux diagnostics d'évaluation. Un modèle qui s'aide à naître, ça pose des questions intéressantes.

⚠️ Classé "HIGH" en cybersécurité. C'est une première chez OpenAI. Leur Preparedness Framework classe GPT-5.3-Codex au niveau "High" en capacité cyber. Le modèle atteint 77.6% sur des challenges CTF de cybersécurité. Concrètement : il est très bon pour trouver des vulnérabilités — ce qui est à la fois utile et préoccupant. OpenAI retarde d'ailleurs l'accès API complet et déploie des contrôles renforcés.

L'accès API arrivera "dans les prochaines semaines". Pour l'instant, le modèle est dispo via ChatGPT (web, CLI, IDE, app Codex) pour les abonnés payants.

Benchmarks : qui gagne quoi ?

Les benchmarks ne disent pas tout, mais ils donnent une grille de lecture. Voici les principaux, vulgarisés.

| Benchmark | Ce que ça mesure | Claude Opus 4.6 | GPT-5.3-Codex | Leader |

|---|---|---|---|---|

| SWE-bench Verified | Résoudre de vrais bugs GitHub (Python) | 80.8% | — | Opus 4.6 |

| SWE-bench Pro | Bugs multi-langages (plus dur) | — | 56.8% | GPT-5.3 |

| Terminal-Bench 2.0 | Tâches complexes en terminal | 65.4% | 77.3% | GPT-5.3 |

| OSWorld | Contrôler un ordi comme un humain | 72.7% | 64.7% | Opus 4.6 |

| BrowseComp | Recherche web autonome | 84.0% | — | Opus 4.6 |

| Cybersecurity CTF | Trouver des vulnérabilités | — | 77.6% | GPT-5.3 |

La synthèse en 3 lignes :

- Pas de gagnant absolu. Chacun domine dans son domaine.

- Claude Opus 4.6 écrase sur le coding général (SWE-bench Verified), l'autonomie (OSWorld) et la recherche web (BrowseComp).

- GPT-5.3-Codex explose les scores en CLI agentic (Terminal-Bench, +12 points vs Opus) et en cybersécurité.

Ce qu'il faut retenir

- 💡 L'app Codex est gratuite temporairement pour les forfaits Free et Go

→ testez maintenant, ça ne durera pas - Le 1M de tokens de contexte d'Opus 4.6 est un game changer pour les grosses codebases

→ plus forcement besoin de découper ses fichiers là où avant on devait le faire - La classification "HIGH" en cybersécurité de GPT-5.3 est un signal fort

→ ces modèles deviennent puissants au point de nécessiter des garde-fous sérieux - On entre dans l'ère des agents autonomes : Agent Teams chez Anthropic, multi-agents Codex chez OpenAI

→ le coding en parallèle devient une norme - La vraie question n'est plus "quel modèle choisir" mais "comment les intégrer intelligemment dans son workflow"

Conclusion

Une semaine historique pour l'AI coding. Deux géants, trois sorties majeures, zéro temps mort. Le vrai gagnant de cette course ? Le développeur.

Sources :