En ce mois de septembre 2025, s’organise à Paris le Snowflake User group. Une opportunité de rencontrer une communauté active présidée par Laurent Letourmy.

Pour cette session, on se plonge dans la thématique de la Data Quality & Observability, une soirée réunissant des acteurs majeurs pour partager leurs retours d'expérience concrets sur ces sujets cruciaux. Entre témoignages terrain et démonstrations techniques, cette soirée a mis en lumière l'évolution que traverse l’industrie data.

De la data quality à la data observability

Benjamin Saal, ex Head of data Gouv de Carrefour, a ouvert les débats en exposant une distinction fondamentale qui structure désormais l'approche des données en entreprise :

"Ce qui marque une différence entre la data quality et l'observabilité, c'est le paradigme d'avant versus aujourd'hui avec les modern stacks."

La data quality traditionnelle s'appuyait sur des contrôles périodiques, souvent manuels, sur des données consolidées et relativement stables. L'observabilité, elle, répond aux exigences du temps réel et de la réactivité qu'imposent les architectures modernes. Une architecture moderne c’est une plateforme data décentralisée mais où les données de toute l’entreprise sont accessibles. Là où les contrôles qualité étaient historiquement silotés entre les équipes marketing, IT et métiers, l'observabilité impose une vision globale et transversale.

Cette décentralisation se traduit par une certaine autonomie mais maîtrisée. Ce cadre c’est l’équipe plateforme qui le met, en préconisant des outils nécessaires à la stabilité et elle viabilise le projet sur le long terme. Le concept de "self-service data quality", inspiré du self-service analytics, devient incontournable.

Le choix du bon outil

La question de l’investissement passe souvent par deux choix: la contractualisation externe ou le développement interne. L'expérience de Carrefour illustre parfaitement l'évolution des approches. Après avoir développé un outil interne ("Clear"), l'entreprise a migré vers une solution externe face aux limites de scalabilité.

Mais au-delà de ce choix, l'expérience de Saint-Gobain, relatée par Maxime Cohen, révèle une vérité souvent occultée :

"Le plus difficile dans un projet d'observabilité, ce n'est pas forcément d'aller paramétrer un outil et de rentrer des règles de qualité dedans. Ça va vraiment être la partie change management et la partie comment j'intègre dans mes processus."

Saint-Gobain a adopté une stratégie de déploiement en trois phases :

1️⃣ déploiement manuel sur les aspects techniques,

2️⃣ déploiement spécifique business,

3️⃣ industrialisation avec monitoring as code et intégration dans les systèmes de ticketing.

Une stratégie qui répond à leur besoin d’observabilité comme étant

"la capacité de comprendre vraiment la santé de notre donnée en allant la traquer tout au long de cette supply chain".

Cette définition se décline en axes de monitoring concrets :

⭐️ fraîcheur des données,

⭐️ distribution,

⭐️ complétude,

⭐️ monitoring de schéma,

⭐️ lineage,

⭐️ consistance.

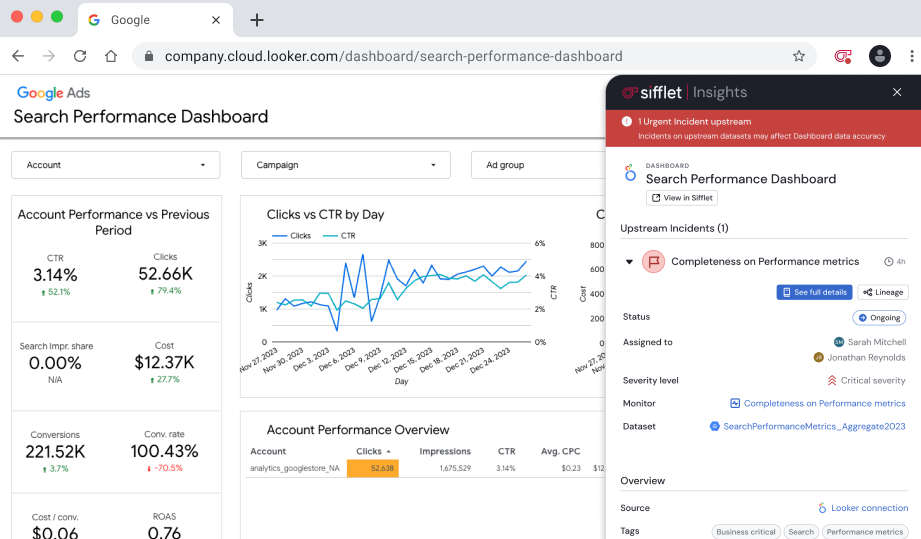

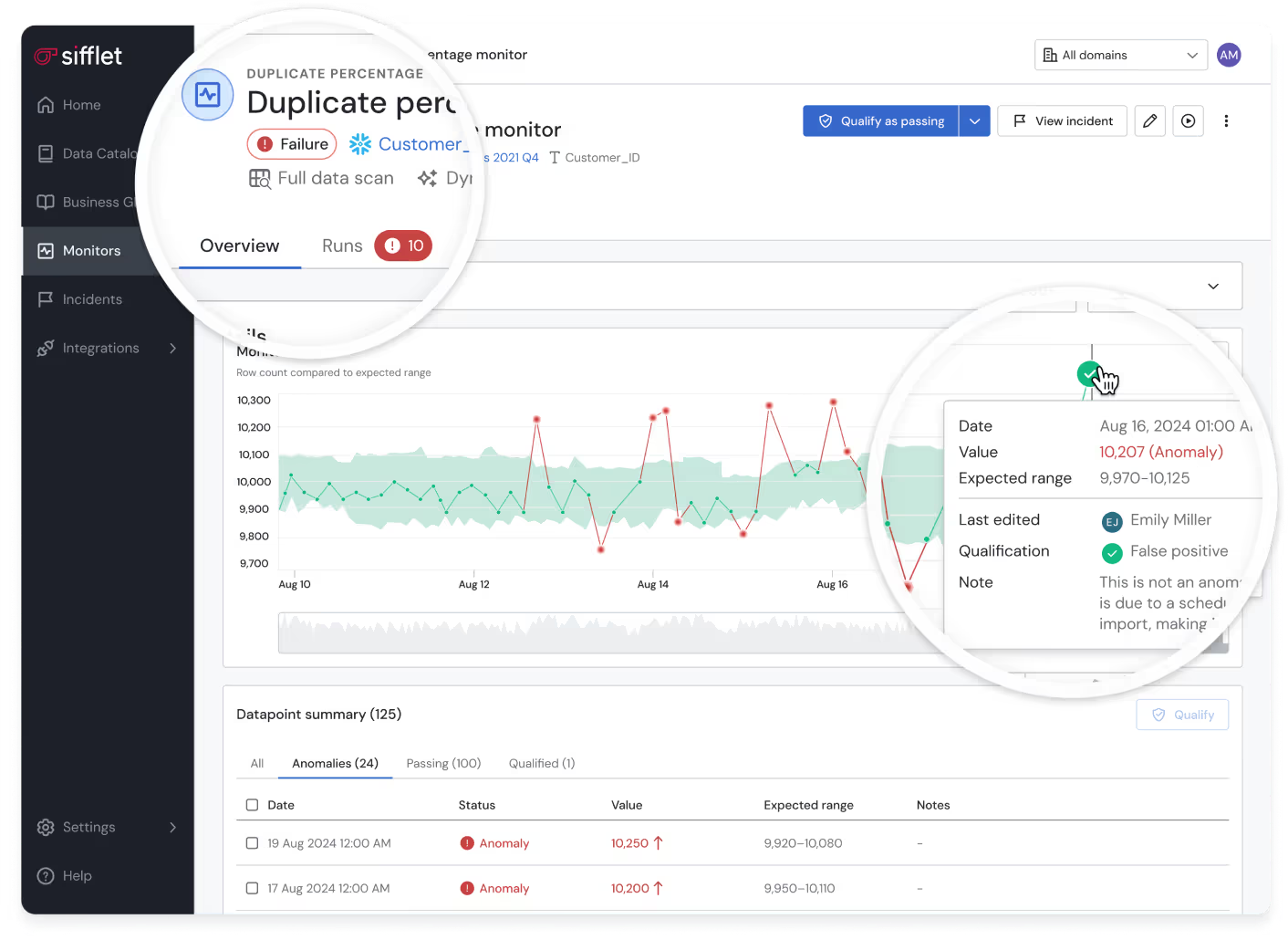

Sifflet : Une plateforme d'observabilité nouvelle génération

La démonstration de Sifflet, réalisée par Shams Roumili, lors de cet événement a parfaitement illustré comment les solutions modernes d'observabilité répondent aux défis identifiés par Carrefour et Saint-Gobain. Cette plateforme française 🇫🇷 se positionne comme une solution centralisée qui unifie producteurs et consommateurs de données, profils métiers et techniques, répondant directement aux enjeux organisationnels soulevés par les intervenants. L'approche de Sifflet s'articule autour de plusieurs innovations clés.

1️⃣ L'extension, dédiée au dashboard (Power BI, Google Ads, Qlick,..), permet de visualiser immédiatement le statut des alertes. Cette approche évite la création de nouveaux silos et facilite l'adoption par les utilisateurs finaux, répondant ainsi à la recommandation de Maxime de ne pas "laisser les business users seuls avec l'outil".

2️⃣ La plateforme intègre pleinement l'intelligence artificielle comme accélérateur de l'observabilité. Les monitors dynamiques définissent automatiquement les plages de valeurs pertinentes grâce au machine learning, réduisant considérablement la charge de configuration manuelle.

Les agents intelligents, disponibles fin 2025, promettent d'aller plus loin en suggérant des stratégies de monitoring, analysant les causes racines et proposant des remédiations automatiques.

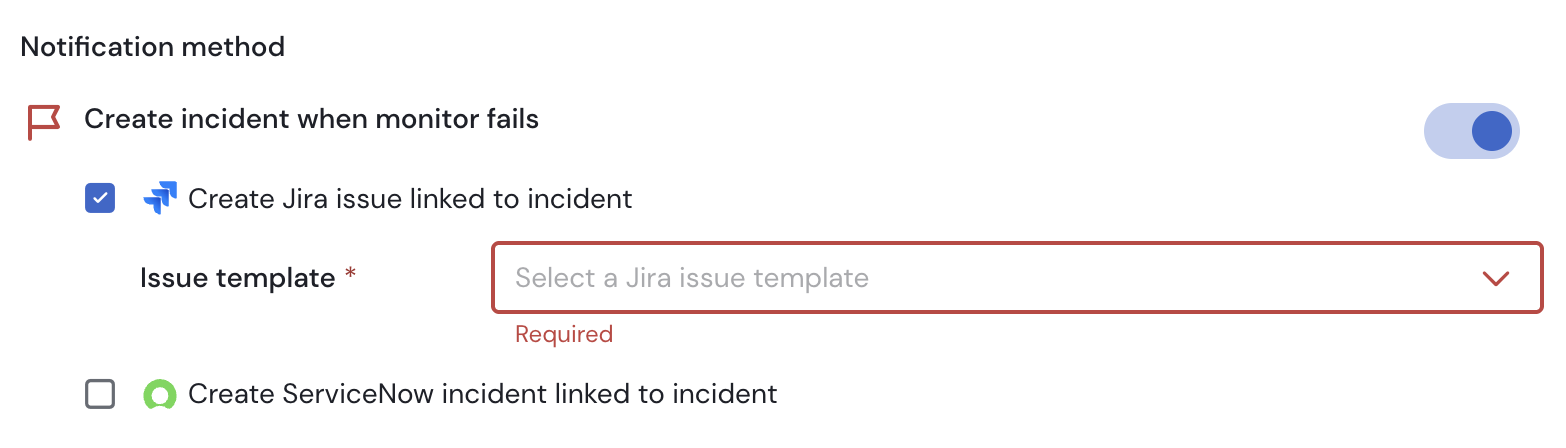

3️⃣ Sifflet adresse également l'importance du facteur humain soulignée par les retours d'expérience. La plateforme propose une gestion complète des incidents avec statuts de suivi, attribution de responsables, niveaux de priorisation et intégration automatique avec les systèmes de ticketing comme Jira ou ServiceNow.

Cette approche répond à l'observation de Maxime :

"On a beau générer des dizaines d'alertes par jour, si ces alertes ne sont pas traitées par des humains derrière, ça ne fonctionne pas."

4️⃣ Enfin, la solution facilite l'intégration précoce de l'observabilité dans les projets grâce à ses templates prêts à l'emploi et son approche "monitoring as code". Cette fonctionnalité permet d'éviter l'écueil classique de la rétrospective et de déployer l'observabilité dès le début des projets, conformément aux recommandations issues des retours d'expérience partagés.

Conclusion

Les retours d'expérience partagés lors de ce Snowflake User Group Paris dessinent les contours d'une transformation profonde de l'écosystème data. L'observabilité des données n'est plus une option mais une nécessité pour les organisations qui souhaitent tirer pleinement parti de leurs actifs data. Chez SFEIR, nous sommes partenaire de Snowflake et nos consultants certifiés et talentueux sont prêts à vous accompagner pour dessiner et implémenter votre plateforme data.

Si cet article vous a plu, je vous propose de me retrouver le 23 octobre prochain, pour une soirée dédiée à "Beyond BI - Snowflake Intelligence". Un intervenant officiel de Snowflake viendra présenter les dernières innovations de la plateforme en matière d'intelligence artificielle et d'analytics avancés. Plus ambitieux encore, le User Group prépare une édition spéciale de l'événement "Build", version française de la conférence développeurs Snowflake, qui marquera une rupture avec le format habituel en proposant un hackathon et des sessions de code pratique hands-on sans slides.

Toi aussi tu es passionné par Snowflake, viens rejoindre la communauté User Group Paris.