En moins de cinq ans, l’IA générative est passée d’une curiosité de laboratoire à une infrastructure mondiale reposant sur des grappes de GPU consommant des mégawatts. Cette expansion s’accompagne d’un défi majeur : le mur énergétique. Les modèles géants exigent une puissance qui croît bien plus vite que l’efficacité des puces, et certains centres de données consomment déjà autant qu’une ville moyenne.

Dans ce contexte apparaît Extropic, fondée par des chercheurs du MIT et de Stanford, qui propose une rupture : le calcul thermodynamique probabiliste.

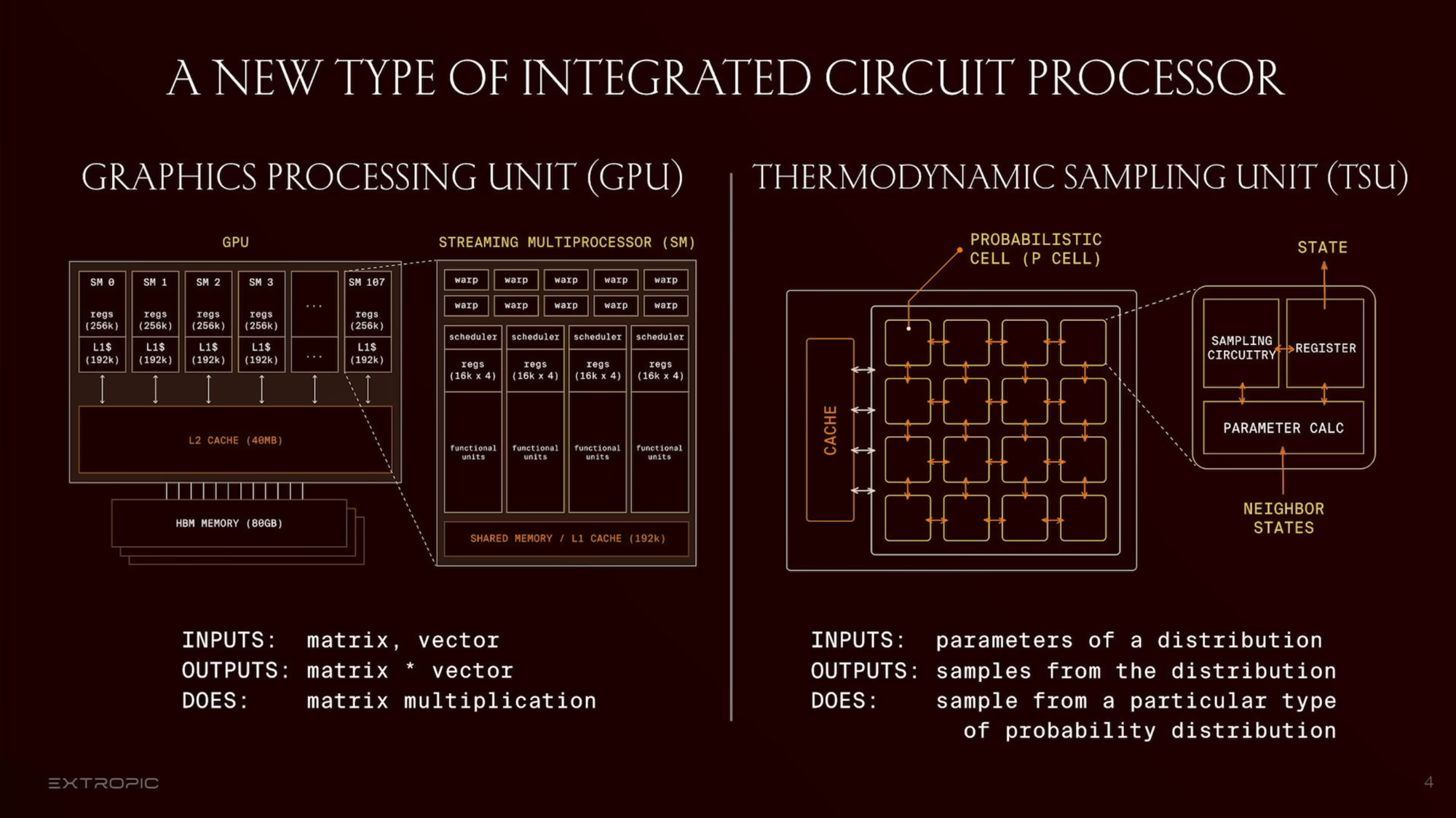

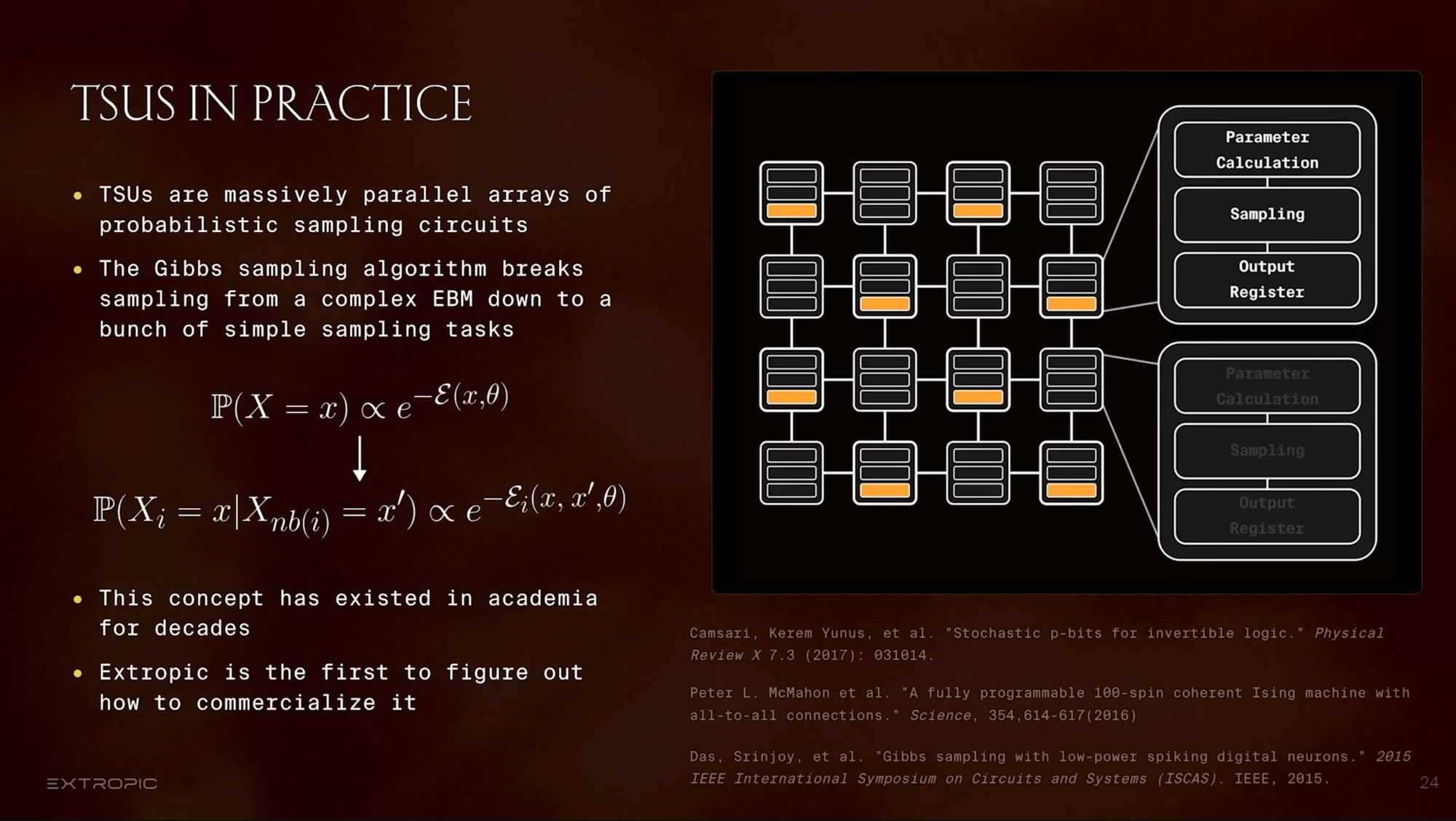

Dans une présentation récente, son CTO décrit une vision où l’on exploite les fluctuations physiques au lieu de les supprimer. Leur matériel, la Thermodynamic Sampling Unit (TSU), ne calcule pas de façon déterministe : il échantillonne des états probables à partir d’une distribution d’énergie, inspirée de la physique statistique.

Cet article résume cette approche, ses fondements et les enjeux énergétiques de l’IA moderne.

Quand la physique reprend la main sur l’IA

Les concepts clés d’Extropic

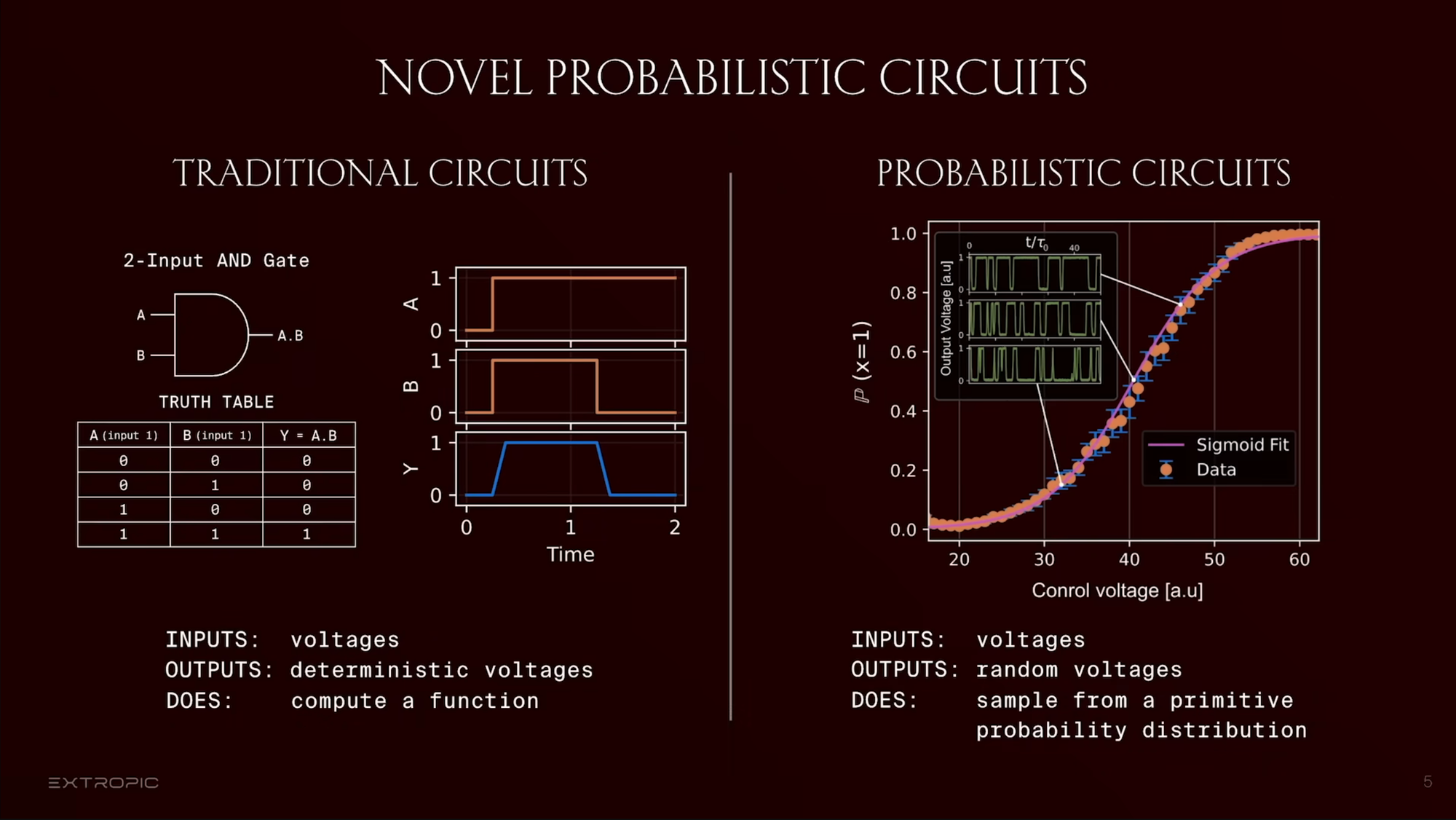

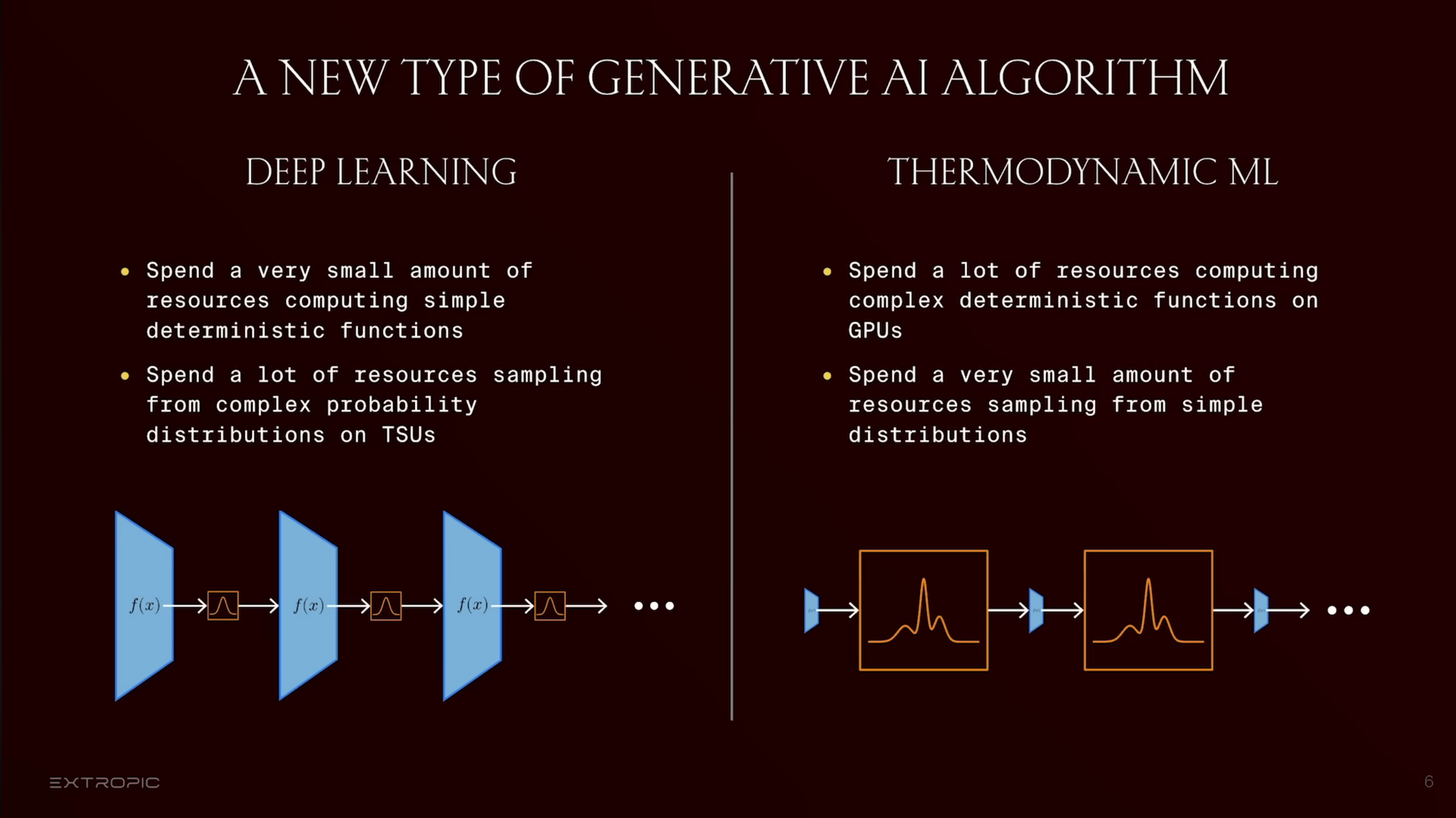

L’informatique classique contraint la matière à se comporter de manière parfaitement déterministe et dépense beaucoup d’énergie à éliminer les fluctuations. Extropic adopte l’inverse : utiliser le bruit thermique comme ressource.

Le composant de base, le p-bit (probabilistic bit), oscille en permanence entre 0 et 1 selon une probabilité ajustable.

En couplant des milliers de p-bits, un TSU explore naturellement des distributions complexes et converge vers un équilibre statistique — un comportement impossible à reproduire efficacement sur GPU.

Un calcul qui incarne les modèles énergétiques

Les TSU reposent sur les principes des Energy-Based Models (EBM) et des Boltzmann Machines, dont ils incarnent directement la dynamique plutôt que de la simuler via des multiplications matricielles.

Les fluctuations thermiques deviennent le moteur de l’échantillonnage : moins d’opérations, moins de mouvements de données, donc un calcul plus rapide et plus économe.

Le goulet d’étranglement énergétique de l’IA

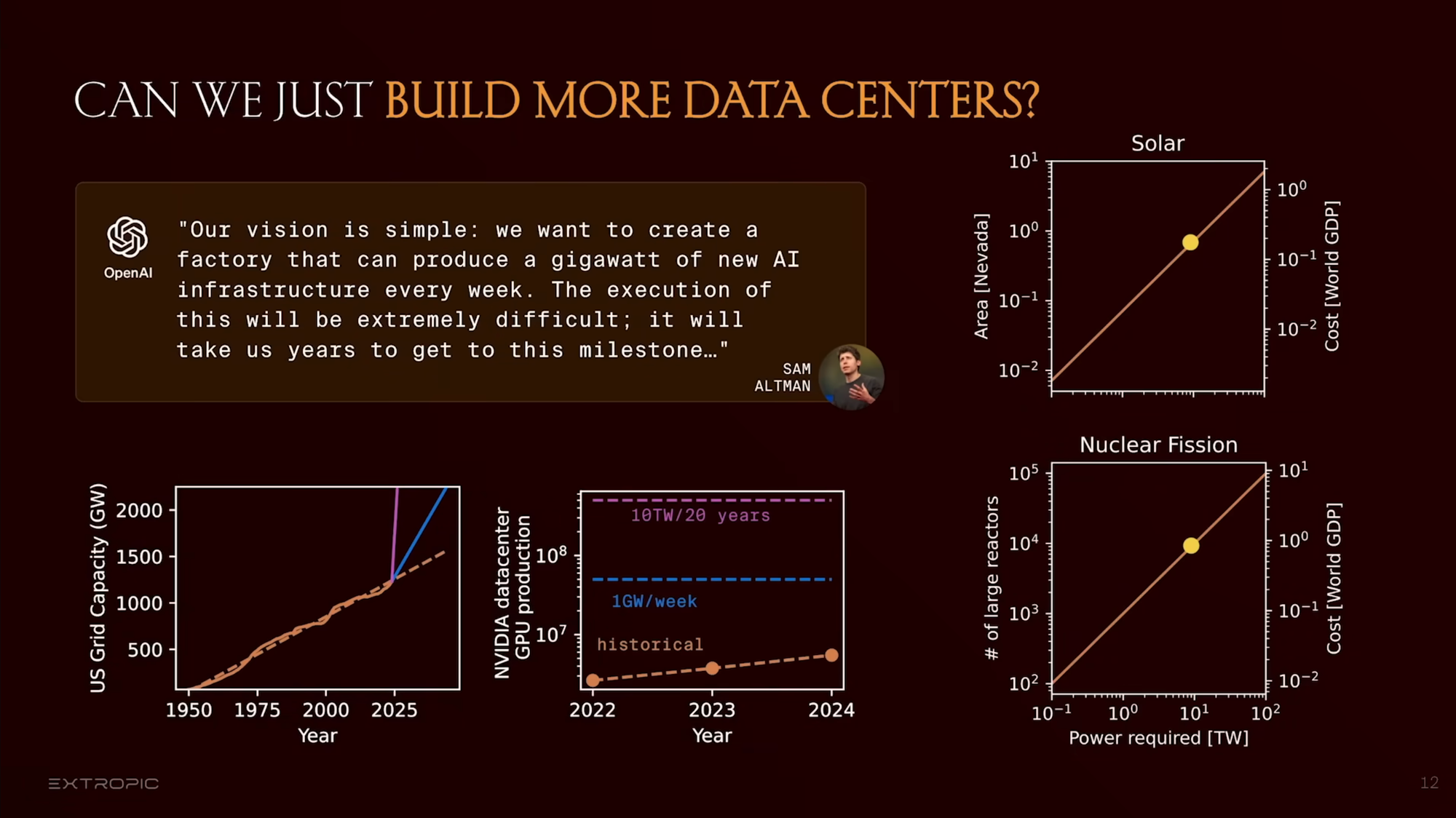

L’IA moderne voit sa demande en énergie doubler tous les 6 à 12 mois (voir Epoch). L’entraînement d’un modèle de 175B de paramètres consommait déjà 1 287 MWh en 2021 (voir l'étude de Berkeley) ; les modèles plus grands atteignent plusieurs GWh. Mais c’est surtout l’inférence quotidienne qui explose.

Selon l’IEA, les data centers IA pourraient atteindre 90 TWh/an d’ici 2026, équivalant à un pays comme l’Autriche.

Les gains d’efficacité des GPU stagnent, alors que les besoins augmentent de plusieurs ordres de grandeur. Le calcul numérique classique se heurte aussi aux limites fondamentales (principe de Landauer) et au coût croissant des transferts de données et du refroidissement.

À ce rythme, l’IA pourrait absorber plus de 10 % de la production électrique mondiale d’ici 2030.

La rupture d’Extropic

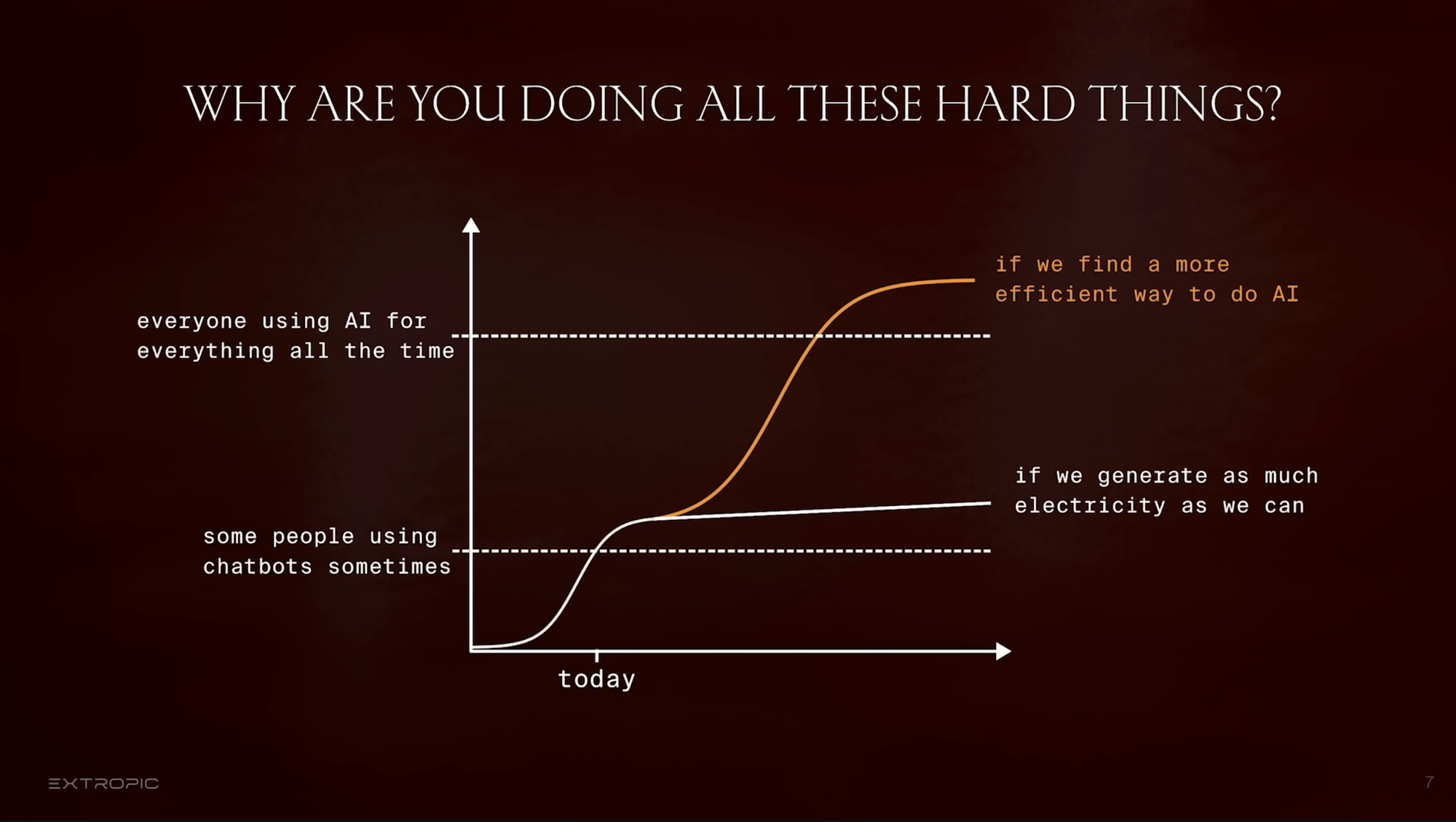

Extropic ne cherche pas à optimiser les architectures numériques mais à changer la nature du calcul.

L’approche locale, distribuée, thermodynamique vise à s’approcher de la limite physique minimale d’énergie par bit traité. L’entreprise avance des gains potentiels de ×10 000 sur certaines tâches probabilistes.

Implications pour les ingénieurs et le logiciel

Extropic oblige à intégrer l’énergie comme métrique centrale :

- mesurer la consommation par tâche ou par inférence ;

- arbitrer qualité / latence / dépenses énergétiques ;

- renforcer les techniques de compression, sparsité, quantification.

L’informatique pourrait évoluer vers des architectures plus locales, où des modèles spécialisés coopèrent au lieu de centraliser un modèle géant dans un seul cluster.

Si les TSU arrivent sur le marché, ils nécessiteront de nouvelles abstractions logicielles : API d’échantillonnage matériel, réintroduction des modèles énergétiques, optimisation par dynamique physique plutôt que par gradient pur.

Ce mouvement marque le retour de la physique au cœur du calcul, après des décennies d’abstraction.

Conclusion : revenir à la matière

L’IA moderne se heurte à une limite fondamentale : chaque bit retourné consomme de l’énergie, et cette dépense augmente plus vite que nos capacités à la compenser.

Extropic propose un retour aux fondations physiques du calcul : laisser la matière effectuer naturellement le travail probabiliste, plutôt que faire tourner toujours plus de GPU.

Cette vision n’est pas seulement matérielle : elle invite à une sobriété conceptuelle, à des systèmes plus locaux, plus proches des dynamiques naturelles, et à une IA conçue comme une organisation physique de l’information, plutôt que comme un empilement abstrait de multiplications matricielles.

Un changement de paradigme, peut-être indispensable, dans un monde où chaque joule compte.